1. C++基础

1.1 指针和引用的区别

- 指针存放某个对象的地址,其本身就是变量(命了名的对象),本身就有地址,所以可以有指向指针的指针;可变,包括其所指向的地址的改变和其指向的地址中所存放的数据的改变

- 引⽤就是变量的别名, 从⼀⽽终,不可变,必须初始化

- 不存在指向空值的引⽤,但是存在指向空值的指针

- 从编译的角度来讲,程序在编译时分别将指针和引用添加到符号表上,符号表中记录的是变量名及变量所对应地址。指针变量在符号表上对应的地址值为指针变量的地址值,而引用在符号表上对应的地址值为引用对象的地址值(与实参名字不同,地址相同)。符号表生成之后就不会再改,因此指针可以改变其指向的对象(指针变量中的值可以改),而引用对象则不能修改。

1.2 C++ 中的指针参数传递和引用参数传递 ⭐

指针参数传递本质上是值传递,它所传递的是一个地址值。值传递过程中,被调函数的形参作为被调函数的局部变量处理,会在栈中开辟内存空间以存放由主调函数传递进来的实参值,从而形成了实参的一个副本。值传递的特点是,被调函数对形参的任何操作都是作为局部变量进行的,不会影响主调函数的实参变量的值实参指针不会变)。但我们可以通过解引用*来修改指针所指向对象的值。

引用参数传递过程中,被调函数的形参也作为局部变量在栈中开辟了内存空间,但是这时存放的是由主调函数放进来的实参变量的地址。被调函数对形参(本体)的任何操作都被处理成间接寻址,即通过栈中存放的地址访问主调函数中的实参变量。因此,被调函数对形参的任何操作都会影响主调函数中的实参变量。

引用传递和指针传递是不同的,虽然他们都是在被调函数栈空间上的一个局部变量,但是任何对于引用参数的处理都会通过一个间接寻址的方式操作到主调函数中的相关变量。而对于指针传递的参数,如果改变被调函数中的指针地址,它将应用不到主调函数的相关变量。如果想通过指针参数传递来改变主调函数中的相关变量(地址),那就得使用指向指针的指针或者指针引用。

从编译的角度来讲,程序在编译时分别将指针和引用添加到符号表上,符号表中记录的是变量名及变量所对应地址。指针变量在符号表上对应的地址值为指针变量的地址值,而引用在符号表上对应的地址值为引用对象的地址值(与实参名字不同,地址相同)。符号表生成之后就不会再改,因此指针可以改变其指向的对象(指针变量中的值可以改),而引用对象则不能修改。

1.3 关键字

1.3.1 const⭐

const的作用:被它修饰的值不能改变,是只读变量,且必须在定义的时候就给它赋初值。- 作用域:由声明位置决定

- 存储期:不会影响变量的存储期

需要注意的是:

常量指针(

const int* a = &temp或int const *a = &temp,也叫底层const)表示这个指针指向⼀个只读的对象,不能通过常量指针来改变这个对象的值 ,但我们可以改变这个指针所指向的对象。指针常量(

int* const p = &temp,也叫顶层const)表示这个指针的值只能在定义时初始化,其他地⽅不能改变。指针常量强调的是指针的不可改变性,即我们不能改变这个指针所指向的对象,但可以改变所指向对象的值。const 在类中的用法:

const 成员变量,只在实例的生命周期内是常量,而对于整个类而言是可以改变的。因为类可以创建多个实例,不同的实例其 const 数据成员值可以不同。所以不能在类的声明中初始化 const 数据成员,因为类的对象在没有创建时候,编译器不知道 const 数据成员的值是什么。const 数据成员的初始化只能在类的构造函数的初始化列表中进行。const 成员函数:const 成员函数的主要目的是防止成员函数修改对象的内容。要注意,const 关键字和 static 关键字对于成员函数来说是不能同时使用的,因为 static 关键字修饰静态成员函数不含有 this 指针,即不能实例化,const 成员函数又必须具体到某一个函数:

this指针冲突:当const修饰成员函数时,C++ 编译器为确保函数不会修改对象状态,会在函数中隐式添加一个this指针(类名 const * const this,this指针既不能改变指向对象,也不能改变指向对象的值),这个指针指向调用函数的对象(类的实例),且既不能改变指向对象的地址,也不能通过它修改对象的值(实例的成员变量)。而static修饰的成员函数属于类本身,并不属于类的某个对象,调用时不依赖类的实例,所以没有this指针 。两者在this指针的处理上是冲突的。- 语意矛盾:

static修饰成员函数时,表明该函数只作用于类的静态变量,和类的实例没有关系;而const修饰成员函数是为了保证函数不会修改类实例的状态,关注的是类的实例,和类的静态变量无关。二者含义相互矛盾,所以不能同时使用。

const 修饰类对象,定义常量对象:常量类对象只能调用常量函数,别的成员函数都不能调用。

- 原因:常量类对象一旦创建,里面的值(成员变量)就不能被修改。比如一个 “不可修改的学生” 对象,它的姓名、年龄等信息都不能被改变。而在

非const成员函数中,函数内部有可能改变对象的值,这对常量对象是不允许的,所以常量对象不能调用非const成员函数,只能调用const成员函数。 - const 成员函数中如果实在想修改某个变量,可以使用 mutable 进行修饰成员变量。成员变量中如果想建立在整个类中都恒定的常量,应该用类中的枚举常量来实现或者 static const。

- 原因:常量类对象一旦创建,里面的值(成员变量)就不能被修改。比如一个 “不可修改的学生” 对象,它的姓名、年龄等信息都不能被改变。而在

1.3.2 static⭐

static 关键字主要用于控制变量和函数的生命周期、作用域以及访问权限。

- 修饰局部变量:一般情况下,对于局部变量在程序中是存放在栈区的,并且局部的生命周期在包含语句块执行结束时便结束了。但是如果用 static 关键字修饰的话,该变量便会存放在静态数据区,其生命周期会一直延续到整个程序执行结束。但是要注意的是,虽然用static 对局部变量进行修饰之后,其生命周期以及存储空间发生了变化,但其作用域并没有改变,作用域还是限制在其语句块。

- 修饰全局变量:对于一个全局变量,它既可以在本文件中被访问到,也可以在同一个工程中其它源文件被访问(添加 extern进行声明即可)。用 static 对全局变量进行修饰改变了其作用域范围,由原来的整个工程可见变成了本文件可见。

- 修饰函数:用 static 修饰函数,情况和修饰全局变量类似,也是改变了函数的作用域。

- 修饰成员函数:属于类而不是类的实例,可以通过类名直接调用,而无需创建对象。静态成员函数不能直接访问非静态成员变量或非静态成员函数。

- 修饰类:如果C++ 中对类中的某个函数用 static 修饰,则表示该函数属于一个类而不是属于此类的任何特定对象;如果对类中的某个变量进行 static 修饰,则表示该变量以及所有的对象所有,存储空间中只存在一个副本,可以通过

::类和对象去调用。- 静态非常量数据成员,其只能在类外定义和初始化,在类内仅是声明 。static 修饰的变量先于类的对象存在,所以 static 修饰的变量要在类外初始化;

- static 成员函数不能被 virtual 修饰,static 成员不属于任何对象或实例,所以加上 vrtual 没有任何实际意义;静态成员函数没有 this 指针,虚函数的实现是为每一个对象分配一个 vptr 指针,而 vptr 是通过 this 指针调用的,所以不能加 virtual;虚函数的调用关系,

this->vptr->ctable(虚表)->virtual function。

1.3.3 define 和 typedef 的区别⭐

含义与功能:

define在C 和 C++ 编译的预处理阶段起作用,主要用于进行简单的文本替换,也称为宏定义,没有类型检查。它可以用来定义常量、函数式宏等。例如,#define PI 3.14159定义了一个名为PI的宏,在预处理阶段,所有出现PI的地方都会被替换为3.14159。define 定义的宏不会分配内存,给出的是立即数,代码中有多少地方使用宏就会进行多少次替换。typedef是 C 和 C++ 中的关键字,用于为已存在的数据类型定义一个新的别名,用来增强代码的可读性和可维护性。例如,typedef int MyInt;定义了MyInt作为int类型的别名,之后就可以使用MyInt来声明变量,就像使用int一样。但

typedef定义的别名与原类型在本质上是同一种类型,在编译时会进行严格的类型检查,主要在编译、运行时起作用。在静态存储区中分配空间,在程序运⾏过程中内存中只有⼀个拷贝。

1.3.4 inline⭐

当函数被声明为

inline时,编译器会尝试在调用该函数的地方将函数代码直接展开,而不是进行常规的函数调用操作。这样可以避免函数调用时保存现场、传递参数、跳转执行等操作带来的开销,提高程序的执行效率。常规函数调用时,先按值传递、指针传递或引用传递方式,将实参传给形参,在栈上为参数分配空间并处理数据;

接着保存当前程序执行状态,包括程序计数器(记录程序执行到的位置)和寄存器的值(上下文),把这些信息压入栈(这些信息将在函数执行完毕后用于恢复程序的执行状态,以便继续执行调用函数之后的代码);

然后修改程序计数器,跳转至被调用函数入口执行函数体,函数体内处理参数、定义和使用局部变量;执行完毕,按返回类型把返回值存到指定位置,再从栈中弹出之前保存的寄存器值和程序计数器值,恢复到调用前状态,最后依据恢复后的程序计数器值,继续执行调用函数之后的代码 。

在 C++ 中,如果在多个源文件中定义了同名的全局变量,链接时会出现冲突。而使用

inline修饰全局变量,就可以在多个源文件中都定义这个变量,但实际上只会有一份变量的实例被创建(但要求所有定义必须一致,不然编译器无法确定使用哪个值),链接器会将这些同名的inline变量合并为一个。

1.3.5 const和define的区别⭐

const用于定义常量;而define用于定义宏,而宏也可以用于定义常量。都用于常量定义时,它们的区别有:

const生效于编译的阶段;define生效于预处理阶段。const定义的常量,在C语言中是存储在内存中、需要额外的内存空间的;define定义的常量,运行时是直接2的操作数,并不会分配内存const定义的常量是带类型的;define定义的常量不带类型。

1.3.6 new 和 malloc的区别 ⭐

new内存分配失败时,会抛出bac_alloc异常,它不会返回NULL;malloc分配内存失败时返回NULL。使用new操作符申请内存分配时无须指定内存块的大小,而

malloc则需要显式地指出所需内存的尺寸。opeartor new /operator delete可以被重载,而malloc/free并不允许重载,因为new/delete是操作符,而malloc/free是库函数。new/delete会调用对象的构造函数/析构函数以完成对象的构造/析构,而malloc则不会。所以new和delete的执行都是两步,调用malloc()分配空间->调用构造函数;或者调用析构函数->调用free()回收空间。new操作符从自由存储区(当程序运行时,操作系统会为程序分配一块堆内存空间,自由存储区就存在于这个堆空间之中,但只有new才能分配)上为对象动态分配内存空间,而malloc函数从堆上动态分配内存。为什么有了

malloc/free还需要new/delete?针对非内部数据类型而言,比如自定义的类,它们在创建时不仅需要分配内存,还必须自动执行构造函数来完成初始化工作;在对象生命周期结束时,需要执行析构函数来释放资源、清理内存等。

malloc/free作为库函数,并不在编译器的直接控制范围内,编译器无法强制它们在分配和释放内存时自动调用构造函数与析构函数。而new/delete是 C++ 的运算符,编译器能够对其进行有效管控,从而确保在创建和销毁对象时,构造函数与析构函数得以正确执行,满足了动态对象全面的管理需求,所以new/delete对于 C++ 的面向对象编程至关重要。

new/delete 时,编译器底层做了什么操作?

在C++中,当我们调用 new/delete 运算符进行对象创建、销毁以及内存分配、释放时,通常包含以下两阶段操作:

- 对

operator new来说,编译器首先会调用底层的库函数malloc()进行内存分配,然后调用对象的构造函数进行对象内容的构造 - 对

operator delete来说,编译器首先会调用对象的析构函数进行对象内容的销毁,然后调用底层库函数free()进行内存的释放

1.3.7 const和volatile的区别⭐

作用:

- **

const**:表示常量,用于修饰变量、函数参数和函数返回值等,表明被修饰的对象的值在初始化后不能被修改,是一种编译时的限定。使用const可以让编译器进行类型检查,防止意外地修改常量值,增强程序的健壮性和可读性。 volatile:表示易变的,用于告诉编译器,被修饰的变量可能会在程序的控制流之外被改变,即变量的值可能会在编译器意想不到的情况下发生变化,比如来自硬件的异步操作或多线程环境中的其他线程。这会使编译器不对该变量进行优化,以确保每次访问该变量时都从内存中读取最新的值,而不是使用可能已经缓存的旧值(寄存器)。

内存访问:

const:对于const修饰的变量,如果编译器能够确定其值不会改变,可能会将其缓存在寄存器中,以提高访问速度。因为编译器认为在程序执行过程中该值始终保持不变,所以可以直接从寄存器中读取,而不需要每次都从内存中获取。volatile:volatile修饰的变量则相反,编译器会严格按照从内存中读取和写入的方式来处理对该变量的访问,即使编译器可能认为从优化的角度可以使用缓存的值,也会强制去内存中获取最新的值,以保证程序能够正确处理变量的意外变化。

举例:

1 | for(volatile int i=0; i<100000; i++){}; // 它会执⾏,不会被优化掉 |

如果不用 volatile 进行修饰,编译器会认为这段代码是空循环,会将其优化。

1.3.8 前置++与后置++

运算顺序:

- **前置 ++**:先将变量的值增加 1,然后再使用变量的新值进行表达式的计算。例如在

int a = 5; int b = ++a;中,先将a的值自增为 6,然后再将a的新值 6 赋给b,最终a和b的值都为 6。 - **后置 ++**:先使用变量原来的值进行表达式的计算,然后再将变量的值增加 1。例如在

int a = 5; int b = a++;中,先将a的值 5 赋给b,然后a的值再自增为 6,最终a的值为 6,b的值为 5。

返回值:

- 前置 ++:返回的是自增后变量的引用。这意味着可以将前置自增的结果继续作为左值使用,即可以对其进行赋值等操作。例如

int a = 5; (++a) = 10;是合法的,最终a的值为 10。 - 后置 ++:返回的是变量自增前的原始值的副本。由于返回的是副本,所以后置自增的结果不能作为左值使用。例如

int a = 5; (a++) = 10;是不合法的,会导致编译错误。

举例:

1 | double arr[5] = {21.2, 32.8, 23.4, 2, 47.43}; |

1.3.9 explicit⭐

C++中的explicit关键字只能用于修饰只有一个参数的类构造函数,它的作用是表明该构造函数是显式的,而非隐式的,跟它相对应的另一个关键字是implicit,意思是隐藏的,类构造函数默认情况下即声明为implicit(隐式)。

这种隐式转换可能导致意外的对象构造,尤其是在无意识的情况下发生(如参数传递、赋值等)。

假如有如下类:

1 | class CxString // 没有使用explicit关键字的类声明, 即默认为隐式声明 |

我们对其进行测试:

1 | CxString string1(24); // 这样是OK的, 为CxString预分配24字节的大小的内存 |

上面的代码中, "CxString string2 = 10" 这句为什么是可以的呢? 在C++中,如果的构造函数只有一个参数时, 那么在编译的时候就会有一个缺省的转换操作:将该构造函数对应数据类型的数据转换为该类对象。 也就是说 "CxString string2 = 10;" 这段代码,编译器自动将整型转换为CxString类对象,实际上等同于下面的操作:

1 | CxString string2(10); |

不过注意,只有当该变量类型和只有一个参数构造函数形参的类型相同时才能发生隐式转换。

1.3.10 final 和 override⭐

借由虚函数实现运行时多态,但C++的虚函数又很多脆弱的地方:

- 无法禁止子类重写它。可能到某一层级时,我们不希望子类继续来重写当前虚函数了。

- 容易不小心隐藏父类的虚函数。比如在重写时,不小心声明了一个签名不一致但有同样名称的新函数。

C++11 提供了 final 来禁止虚函数被重写/禁止类被继承,override 来显式地重写虚函数。这样编译器给我们不小心的行为提供更多有用的错误和警告。

1.3.11 constexpr和const的区别

const的特性

- 运行时常量:

const修饰的变量可以在运行时初始化,一旦初始化就不能再修改。 - 修饰对象广泛:

const既能修饰变量,也能修饰函数参数、返回值、成员函数等。

constexpr的特性

- 编译时常量:

constexpr修饰的变量或者函数,其值在编译时就能确定。这有助于编译器在编译阶段进行优化。 - 用途有限:

constexpr主要用于修饰变量和函数,以确保其在编译时可求值。

区别总结:

- 初始化时间:

const变量可以在运行时初始化,而constexpr变量必须在编译时初始化。 - 编译器优化:由于

constexpr变量在编译时就已确定值,编译器可以进行更多优化。 - 使用场景:

const常用于确保变量在初始化后不会被修改,而constexpr主要用于模板编程、数组大小定义等需要编译时常量的场景。

3. 代码示例

1.4 C和C++的区别(函数/类/struct/class)⭐

- 语言性质:C是面向过程编程,而C++是面向对象编程

- 类和对象:

- C语言:没有类和对象的概念,主要通过结构体来组织数据和相关操作函数,但结构体只是数据的集合,不具备面向对象编程中类的封装、继承和多态等特性。默认成员访问权限和继承权限是

public。 - C++:引入了类的概念,将数据和操作数据的方法封装在类中,通过创建类的对象来访问和操作这些数据和方法,支持面向对象编程的三大特性:封装、继承和多态。默认成员访问权限和继承权限是

private。

- C语言:没有类和对象的概念,主要通过结构体来组织数据和相关操作函数,但结构体只是数据的集合,不具备面向对象编程中类的封装、继承和多态等特性。默认成员访问权限和继承权限是

- 函数重载:⭐

- C 语言:不支持函数重载,并且没有虚函数的概念。

- **C++**:支持函数重载,且支持多态。

- C不支持重载的原因:因为C++ 函数的名字修饰与C不同,C++ 函数名字的修饰会将参数加在后面,例如,int func(int,double)经过名字修饰之后会变成_func_int_double,这样即使同名函数但在编译器编译和链接时都会有唯一一个内部名称用于分别重载函数;而C中则会变成 func,所有同名函数共用一个名称,所以 C++ 中会支持不同参数调用不同函数。

1.5 说⼀下 C++ 是怎么定义常量的?常量存放在内存的哪个位置?⭐

定义常量一般使用两种方式:const关键字修饰或#define预处理指令。

- 全局常量和静态常量:全局作用域中定义的常量以及类中的静态常量,如果是基本数据类型且值在编译时可确定,通常会存储在全局静态区(.data)中。这部分内存区域在程序运行期间是只读的,防止程序意外修改常量的值。

- 局部常量:一般存储在栈区,当超出作用域范围后,栈上的空间会被释放。

- 用

new动态分配的常量:通过new关键字动态分配内存创建的常量,会存储在堆区中的自由存储区中。

1.6 C++ 中重载、重写和重定义的区别 ⭐

- 重载:指同⼀可访问区内被声明的⼏个具有不同参数列表的同名函数,依赖于 C++函数名字的修饰会将参数加在后⾯(每个函数都有自己的内部名称,即使外部同名,但内部名字仍然不同),可以是参数类型,个数,顺序的不同。根据参数列表决定调⽤哪个函数,重载不关⼼函数的返回类型。

- 重写:派生类中重新定义父类中除函数体外完全相同的虚函数,注意被重写的函数不能是 static 的,一定要是虚函数(static和virtual不能共用,static没有this指针,而虚函数的调用需要this指针),且其他一定要完全相同。要注意,重写和被重写的函数是在不同的类当中的,重写函数的访问修饰符是可以不同的,尽管 virtual 中是 private 的,派生类中重写可以改为 public。

- 重定义(隐藏):派生类重新定义父类中相同名字的非 virtual 函数;参数列表和返回类型都可以不同,即父类中除了定义成 virtual 且完全相同的同名函数才不会被派生类中的同名函数所隐藏(重定义)。

1.7 C++ 的四种强制转换⭐

C++ 的四种强制转换分别是static_cast、reinterpret_cast、const_cast和dynamic_cast:

static_cast:用于具有明确定义的类型转换,在使用时最好明确指出类型转换,如基本数据类型之间的转换,以及有继承关系的类之间的指针或引用转换。但不能用于去除const等常量属性,也不能在不相关的类型之间进行转换,比如指针和int,两个没有继承关系的类之间就不可以转换。上行转换(派生类->基类)安全,下行转换(基类->派生类)不安全。dynamic_cast:主要用于在有继承关系的类之间进行安全的向下转型,即从基类指针或引用转换为派生类指针或引用。它在运行时进行类型检查,如果转换失败,对于指针类型会返回nullptr,对于引用类型会抛出std::bad_cast异常,常用于多态场景下确定对象的实际类型。reinterpret_cast:主要用于将一种指针类型转换为另一种完全不同的指针类型,或者将整数类型与指针类型进行转换,它是最底层的、最不安全的转换方式,可能会导致不可预测的结果,应谨慎使用。比如将int*转成char*。const_cast:专门用于去除对象的const或volatile属性,使原本只读的对象可以被修改,但如果对一个真正的常量进行这种操作,会导致未定义行为。常用于函数需要修改传入的const对象的场景。

1.8 函数指针 ⭐

从定义和用途两方面来说一下自己的理解:

- 首先是定义:函数指针是指向函数的指针变量。函数指针本身首先是一个指针变量,该指针变量指向一个具体的函数。这正如用指针变量可指向整型变量、字符型、数组一样,这里是指向函数,存储函数的地址。

在编译时,每一个函数都有一个入口地址,该入口地址就是函数指针所指向的地址。有了指向函数的指针变量后可用该指针变量调用函数,就如同用指针变量可引用其他类型变量一样,在这些概念上是大体一致的。 - 其次是用途:调用函数和做函数的参数,比如回调函数。

1 | int add(int a, int b) { |

注意区分函数指针和指针函数的区别:前者是指向函数的指针变量 ,后者是⼀个返回指针类型的函数,⽤于返回指向某种类型的数据的指针 。

1.9 封装、继承、多态 、虚函数表、联编、纯虚函数⭐⭐⭐

设计模式(1)——面向对象和面向过程,封装、继承和多态 | 爱吃土豆的个人博客

1.10 编译器如何处理虚函数表

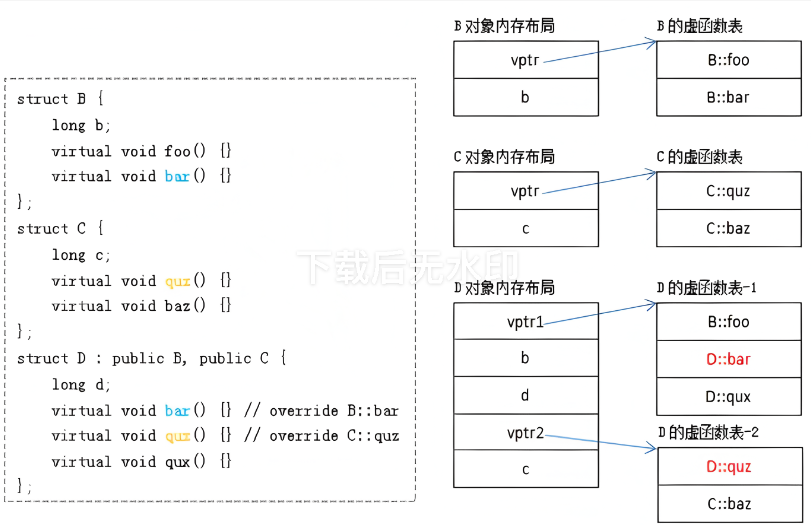

对于派生类来说,编译器建立虚函数表一共有三个步骤:

第一步:拷贝基类虚函数表:

若派生类是单继承,编译器会直接拷贝基类的虚函数表;要是多继承的情况,编译器会拷贝每个含有虚函数的基类的虚函数表。这里存在一种特殊情形,即可能有某个基类的虚函数表和派生类自身的虚函数表共用一个,此基类被称作派生类的主基类。

第二步:替换重写的虚函数地址:

编译器会检查派生类中是否存在重写基类虚函数的情况。若有,就会把虚函数表中对应基类虚函数的地址,替换为派生类中重写后的虚函数地址。这一操作能保证在运行时,当通过基类指针或引用调用虚函数时,实际调用的是派生类中重写后的版本。

第三步:追加派生类自身的虚函数:

编译器会查看派生类是否定义了自身特有的虚函数。若存在,就会将这些派生类自身的虚函数地址追加到派生类的虚函数表中。如此一来,当调用这些派生类特有的虚函数时,就能正确地找到对应的函数实现。

1.11 析构函数⼀般写成虚函数的原因 ⭐

为了降低内存泄漏的可能性。

举例来说就是,一个基类的指针指向一个派生类的对象,在使用完毕准备销毁时,如果基类的析构函数没有定义成虚函数,那 么编译器根据指针类型就会认为当前对象的类型是基类,调用基类的析构函数 (该对象的析构函数的函数地址早就被绑定为基类的析构函数),仅执行基类的析构,派生类的自身内容将无法被析构,造成内存泄漏。

如果基类的析构函数定义成虚函数,那么编译器就可以根据实际对象,执行派生类的析构函数,再执行基类的析构函数,成功释放内存。

1.12 构造函数为什么⼀般不定义为虚函数⭐

虚函数调用只需要知道“部分的”信息,即只需要知道函数接口,而不需要知道对象的具体类型。但是,我们要创建一个对象的话,是需要知道对象的完整信息的。特别是,需要知道要创建对象的确切类型,因此,构造函数不应该被定义成虚函数;

而且从目前编译器实现虚函数进行多态的方式来看,虚函数的调用是通过实例化之后对象的虚函数表指针来找到虚函数的地址进行调用的,如果说构造函数是虚的,那么虚函数表指针则是不存在的(因为构造函数是虚的,那么同样需要虚函数表来进行调用,但是虚函数表只有在调用构造函数之后才会生成,自相矛盾了),无法找到对应的虚函数表来调用虚函数,那么这个调用实际上也是违反了先实例化后调用的准则。

1.13 构造函数或析构函数中调用虚函数会怎样⭐

在派生类构造函数或析构函数中调用虚函数不会展现出多态特性。

- 当在构造函数中调用虚函数时,调用的是当前构造函数所属类的虚函数版本,而不是派生类重写的版本。这是因为在构造派生类对象时,会先调用基类的构造函数,此时派生类部分还未完全构造好(派生类的虚函数表还未形成,无法调用派生类的虚函数),编译器只能保证基类部分是有效的,所以调用虚函数时只能调用基类的版本

- 在析构函数中调用虚函数,调用的同样是当前析构函数所属类的虚函数版本。这是因为在销毁派生类对象时,会先调用派生类的析构函数,之后再调用基类的析构函数,当进入基类析构函数时,派生类部分已经被销毁,此时只能调用基类的虚函数版本。

在基类的构造函数中是无法调用的,因为基类此时还未构造,虚函数表还未生成,无法调用。

1.14 构造函数的析构函数的执行顺序

构造函数顺序:

- 首先调用基类构造函数。如果有多个基类,则构造函数的调用顺序是某类在类派生表中出现的顺序,而不是它们在成初始化表中的顺序。

- 然后调用成员类对象构造函数。如果有多个成员类对象则构造函数的调用顺序是对象在类中被声明的顺序,而不是它出现在成员初始化表中的顺序。

- 最后调用派生类构造函数。

析构函数顺序:

- 调用派生类的析构函数;

- 调用成员类对象的析构函数;

- 调用基类的析构函数。

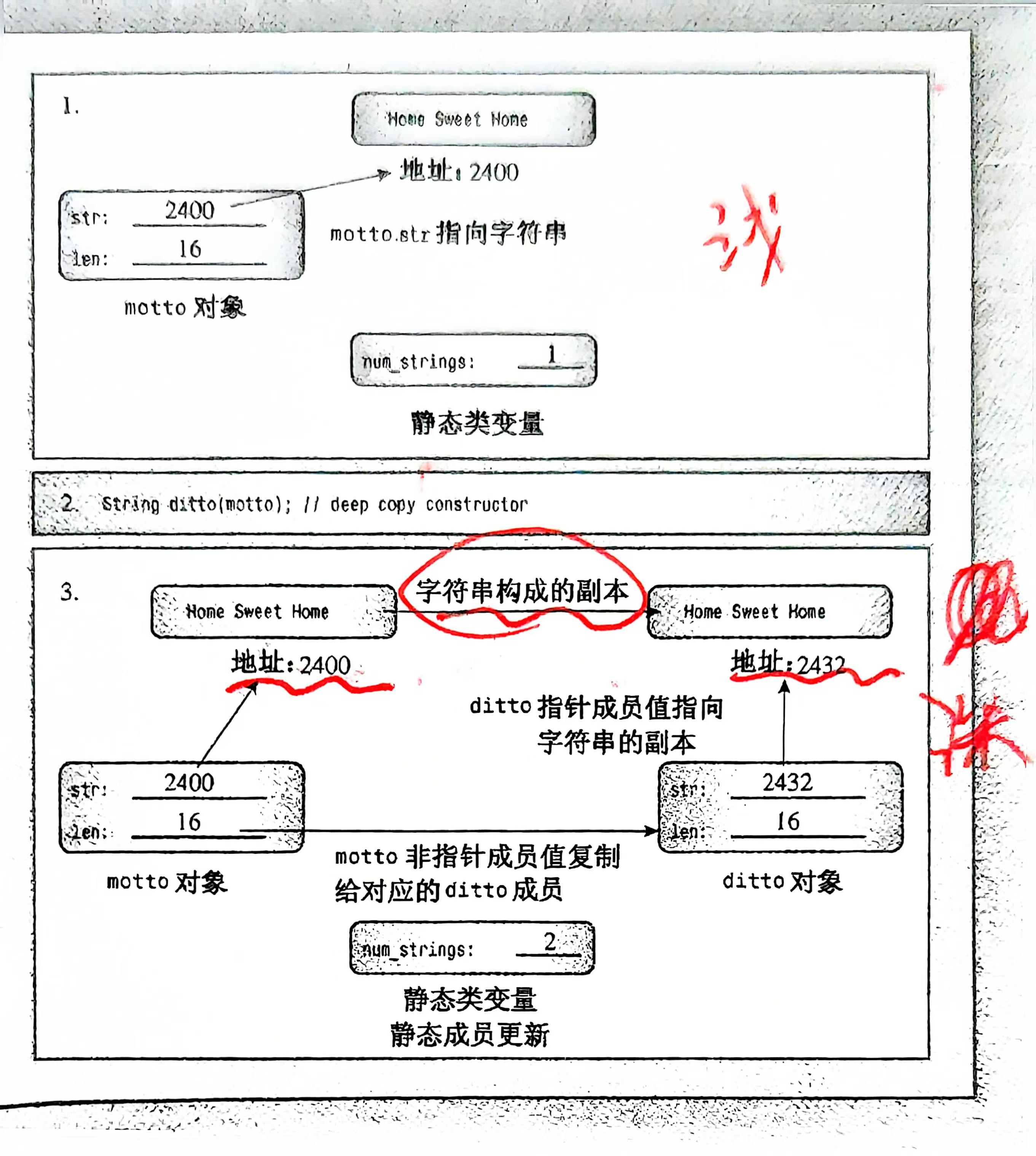

1.15 深拷贝和浅拷贝⭐

当出现类的等号赋值时,会调用拷贝函数,在未定义显示拷贝构造函数的情况下,系统会调用默认的拷贝函数,即浅拷贝,它能够完成成员的一一复制。当数据成员中没有指针时,浅拷贝是可行的。

但当数据成员中有指针时,如果采用简单的浅拷贝,则两类中的两个指针指向同一个地址,当两个对象共享同一个指针,其中一个对象析构时释放了内存,另一个对象的指针就变成了悬空指针。另外,如果两个对象都尝试释放同一个内存,就会导致重复释放。还有,如果其中一个对象修改了指针指向的内容,另一个对象也会受到影响,因为它们指向同一块内存。

所以,这时必需采用深拷贝。深拷贝与浅拷贝之间的区别就在于深拷贝会在堆内存中另外申请空间来存储数据,从而也就解决来野指针的问题。简而言之,当数据成员中有指针时,必需要用深拷贝更加安全。

当然,我们也可以通过智能指针管理对象,智能指针会自行管理内存。

浅拷贝:只复制对象的值或引用,多个对象共享同一个动态分配的内存空间,修改其中一个对象的数据会影响到另一个对象。

深拷贝:复制对象本身的值,并且对对象引用的内存进行递归复制,确保每个对象拥有独立的内存,修改其中一个对象的数据不会影响另一个对象。

1.16 什么情况下会调用拷贝构造函数(三种情况)

类的对象需要拷贝时,拷贝构造函数(不是默认构造)将会被调用,以下的情况都会调用拷贝构造函数:

- 一个对象以值传递的方式传入函数体,需要拷贝构造函数创建一个临时对象压入到栈空间中。

- 一个对象以值传递的方式从函数返回,需要执行拷贝构造函数创建一个临时对象作为返回值。

- 一个对象需要通过另外一个对象进行初始化。

1.17 为什么拷贝构造函数必须加const &?⭐

为了防止递归调用。当一个对象需要以值方式进行传递时,编译器会生成代码调用它的拷贝构造函数生成一个副本,如果类A的拷贝构造函数的参数不是引用传递,而是采用值传递,那么就又需要为了创建传递给拷贝构造函数的参数的临时对象,而又一次调用类 A的拷贝构造函数,这就是一个无限递归。

1) 拷贝构造函数的标准写法: 通常情况下,拷贝构造函数的声明为:

1 | ClassName(const ClassName& other); |

这样可以避免在传递对象时进行额外的拷贝操作,因为参数是以引用的方式传递的

2) 传值方式的拷贝构造函数: 如果不加 &,而是像这样声明:

1 | ClassName(ClassName other); |

这意味着拷贝构造函数的参数是按值传递的。按值传递要求创建一个临时的拷贝,这就需要再次调用拷贝构造函数来创建这个参数的拷贝

无限递归: 当拷贝构造函数以按值传递的方式声明时,每次调用拷贝构造函数都会再次调用自己来创建参数的拷贝,导致无限递归。这样会导致程序崩溃(栈溢出)

自己拷贝自己:此外,在实现拷贝赋值运算符时,如果对象不小心将自己作为右值传入,就会发生“自己拷贝自己”的情况。常见的做法是在赋值前检查是否是“自己拷贝自己”,如下所示:

1 | ClassName& operator=(const ClassName& other) { |

1.18 预处理,编译,汇编,链接程序的区别⭐

一段高级语言代码需要经过四个阶段的处理,最终形成可执行的目标二进制代码。这四个阶段依次为:预处理器→编译器→汇编器→链接器。

- 预处理阶段:当我们编写好如

hello.c这样的高级语言程序文本后,预处理器会依据以#开头的命令对原始程序进行修改。例如,#include <stdio.h>指令会将系统中的头文件插入到程序文本里,预处理后的文件通常以.i结尾。 - 编译阶段:编译器会把

hello.i文件翻译成文本文件hello.s,这是一个汇编语言程序。需要注意区分概念,高级语言编写的是源程序,而汇编语言程序的每条语句都以标准的文本格式精确描述一条低级机器语言指令。不同的高级语言经过编译后可能会生成相同的汇编语言程序。 - 汇编阶段:汇编器会把

hello.s文件翻译成机器语言指令,并将这些指令打包成可重定位目标程序,也就是.o文件。hello.o是一个二进制文件,其字节码为机器语言指令,不再是字符形式,而前两个阶段处理后的文件仍包含字符。 - 链接阶段:以

hello程序为例,若它调用了printf函数,这是每个 C 编译器都会提供的标准库 C 中的函数,该函数存在于一个单独编译好的目标文件printf.o中。链接器的作用就是将printf.o以某种方式合并到hello.o中,最终得到可执行目标文件。

1.19 动态编译与静态编译 ⭐

静态编译:

- 原理:在静态编译过程中,编译器会将程序所依赖的所有库文件(如函数库等)的代码都完整地包含到最终生成的可执行文件中。也就是说,可执行文件包含了运行所需的全部代码,不依赖外部的库文件来提供功能。

- 优点:可移植性强,因为可执行文件自身包含了所有必要的代码,在任何支持该平台的环境中都可以直接运行,无需额外安装依赖库。

- 缺点:生成的可执行文件体积较大,因为包含了大量的库代码;而且如果库文件更新,需要重新进行编译。

动态编译:

- 原理:动态编译生成的可执行文件并不包含所依赖库的完整代码,而是在程序运行时才去加载所需的动态链接库(

DLL,在 Windows 系统中)或共享对象文件(.so,在 Linux 系统中)。这些动态库可以被多个程序共享使用。 - 优点:生成的可执行文件体积较小,因为不包含库的代码;并且库文件更新时,只要接口不变,可执行文件无需重新编译就能使用新的库功能。

- 缺点:程序运行依赖于系统中存在相应的动态库,如果缺少这些库,程序将无法正常运行,这在一定程度上降低了程序的可移植性。

1.20 动态链接和静态链接⭐

静态链接库就是把(lib) 文件中用到的函数代码直接链接进目标程序,程序运行的时候不再需要其它的库文件;动态链接就是把调用的函数所在文件模块(DLL)和调用函数在文件中的位置等信息链接进目标程序,程序运行的时候再从 DLL 中寻找相应函数代码,因此需要相应 DLL 文件的支持。

静态链接库与动态链接库都是共享代码的方式,如果采用静态链接库,则无论你愿不愿意,lib 中的指令都全部被直接包含在最终生成的 EXE 文件中了。但是若使用 DLL,该 DLL不必被包含在最终 EXE 文件中,EXE 文件执行时可以“动态”地引用和卸载这个与 EXE 独立的 DLL 文件。

静态链接库和动态链接库的另外一个区别在于要包含的静态链接库中不能再包含其他的动态链接库或者静态库,而在动态链接库中还可以再包含其他的动态或静态链接库。

动态库就是在需要调用其中的函数时,根据函数映射表找到该函数然后调入堆栈执行。如果在当前工程中有多处对.dll文件中同一个函数的调用,那么执行时,这个函数只会留下一份拷贝。但如果有多处对 .lib 文件中同一个函数的调用,那么执行时该函数将在当前程序的执行空间里留下多份拷贝,而且是一处调用就产生一份拷贝。

1.21 动态联编与静态联编 ⭐⭐

设计模式(1)——面向对象和面向过程,封装、继承和多态 | 爱吃土豆的个人博客

1.22 构造函数、析构函数可否抛出异常⭐

构造函数允许抛出异常。在构造对象的过程中,可能会遇到各种错误情况,比如内存分配失败、文件打开失败、网络连接失败等,此时可以通过抛出异常来通知调用者对象构造失败。

- 对象构造未完成:一旦构造函数抛出异常,对象的构造过程就会终止,已经分配的部分资源会被正确释放(如果在抛出异常前有相应的资源管理机制),并且对象不会被创建成功。

- 局部对象的析构:如果构造函数在初始化列表或者函数体中创建了局部对象,当构造函数抛出异常时,这些已经成功构造的局部对象会按照与构造顺序相反的顺序自动调用析构函数进行析构。

析构函数通常不应该抛出异常。

可能导致程序崩溃:如果析构函数抛出异常,并且在异常处理过程中又有其他异常抛出(例如,在析构过程中调用的其他函数也抛出异常),会导致程序进入未定义行为,很可能会使程序崩溃。

异常安全问题:在对象销毁的过程中,通常是为了释放资源,如果析构函数抛出异常,可能会导致部分资源无法正确释放,从而引发资源泄漏。

必须抛出异常时:如果析构函数中确实可能会出现异常情况,可以在析构函数内部捕获异常并进行处理,而不是将异常抛出。

1.23 何时需要成员初始化列表?过程是什么?⭐

- 当对引用成员变量进行初始化时;

- 当对

const成员变量进行初始化时; - 成员变量是一个禁止拷贝的变量时;成员初始化列表是在对象构造时直接进行初始化,避免了赋值和拷贝的过程,所以可以用于初始化禁止拷贝的变量。

- 当调用基类的构造函数,且该构造函数带有一组参数时;

- 当调用成员类的构造函数,且该构造函数带有一组参数时;

编译器会对初始化列表进行处理,它会按照恰当的顺序,在构造函数内部插入初始化操作,并且这些操作会在任何用户显式编写的代码之前执行。需要注意的是,初始化列表中项目的执行顺序是由类中成员的声明顺序所决定的,而非初始化列表里的排列顺序。

1.24 程序员定义的析构函数被扩展的过程⭐

在 C++ 中,程序员定义的析构函数在编译阶段会被编译器进行扩展,以确保对象在销毁时能正确处理各种资源和执行必要的操作。

1. 执行用户自定义的析构函数代码

执行析构函数内部代码

2. 调用成员对象的析构函数

如果类包含成员对象,编译器会在用户自定义的析构函数代码之后,按照成员对象在类中声明的相反顺序调用它们的析构函数。这是为了确保成员对象的资源能够被正确释放。

3.如果对象有⼀个 vptr,会被重新新定义

当对象开始析构时,在执行用户自定义的析构函数代码之前,编译器会确保 vptr 仍然指向当前对象实际类型对应的虚函数表。这是因为在析构的早期阶段,对象仍然是完整的,其行为应该遵循当前类型的定义。

随着析构过程的推进,当成员对象和基类部分开始析构时,vptr 会逐步调整。在调用成员对象的析构函数时,vptr 不会改变,因为此时对象的主要类型特性还是当前类。当开始调用基类的析构函数时,vptr 会被调整为指向基类的虚函数表。这是因为在基类析构期间,对象的派生类部分已经被销毁,对象的行为应该遵循基类的定义。例如,在一个多层继承体系中,当从派生类析构进入基类析构时,vptr 会从指向派生类虚函数表切换到指向基类虚函数表,以保证在基类析构函数中调用虚函数时,调用的是基类版本的函数。

4. 调用基类的析构函数

如果类是派生类,编译器会在成员对象的析构函数调用之后,调用其直接基类的析构函数。如果基类还有基类,会按照继承层次从下往上依次调用各级基类的析构函数

5. 释放对象占用的内存

在完成上述所有操作后,编译器会安排释放对象本身占用的内存。对于栈上的对象,这通常由操作系统自动完成;对于堆上的对象,会调用 delete 或 delete[] 来释放内存。

1.25 构造函数的执行步骤⭐

- 在派生类构造函数中,所有的虚基类及上一层基类的构造函数被调用;

- 对象的 vptr 被初始化

- 如果有成员初始化列表,将在构造函数体内扩展开来,这必须在vptr 被设定之后才做;

- 执行程序员所提供的代码;

1.26 构造函数的扩展过程

- 记录在成员初始化列表中的数据成员初始化操作会被放在构造函数的函数体内,并与成员的声明顺序为顺序;

- 如果一个成员并没有出现在成员初始化列表中,但它有一个默认构造函数,那么默认构造函数必须被调用;

- 如果 class 有虚表,那么它必须被设定初值,即初始化;

- 所有上一层的基类构造函数必须被调用;

- 所有虚基类的构造函数必须被调用

1.27 哪些函数不能是虚函数⭐

构造函数,虚函数调用只需要知道“部分的”信息,即只需要知道函数接口,而不需要知道对象的具体类型。但是,我们要创建一个对象的话,是需要知道对象的完整信息的。特别是,需要知道要创建对象的确切类型,因此,构造函数不应该被定义成虚函数;

而且从目前编译器实现虚函数进行多态的方式来看,虚函数的调用是通过实例化之后对象的虚函数表指针来找到虚函数的地址进行调用的,如果说构造函数是虚的,那么虚函数表指针则是不存在的(因为构造函数是虚的,那么同样需要虚函数表来进行调用,但是虚函数表只有在调用构造函数之后才会生成,自相矛盾了),无法找到对应的虚函数表来调用虚函数,那么这个调用实际上也是违反了先实例化后调用的准则。

内联函数,内联函数表示在编译阶段进行函数体的替换操作,而虚函数意味着在运行期间进行类型确定,所以内联函数不能是虚函数;

静态函数,静态函数不属于对象属于类,静态成员函数没有this指针,因此静态函数设置为虚函数没有任何意义。

友元函数,友元函数不属于类的成员函数,不能被继承。对于没有继承特性的函数没有虚函数的说法。

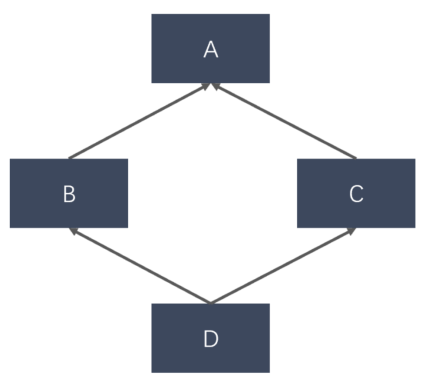

1.28 菱形继承⭐

一个类可以从多个基类(父类)继承属性和行为。在C++等支持多重继承的语言中,一个派生类可以同时拥有多个基类。

多重继承可能引入一些问题,如萎形继承问题,比如存在同时继承了两个拥有相同基类的类,而最终的派生类又同时继承了这两个类时, 可能导致二义性和代码设计上的复杂性。为了解决这些问题,C++ 提供了虚继承,通过在继承声明中使用 virtual 关键字,可以避免在派生类中生成多个基类的实例,从而解决了萎形继承带来的二义性。

1 | // 公共基类 |

1.29 虚函数和纯虚函数的区别⭐

虚函数:

- 有实现:虚函数有函数声明和实现,即在基类中可以提供默认实现。

- 可选实现: 派生类可以选择是否覆盖虚函数。如果派生类没有提供实现,将使用基类的默认实现。

- 允许实例化: 虚函数的类可以被实例化。即你可以创建一个虚函数的类的对象。

- 调用靠对象类型决定: 在运行时,根据对象的实际类型来决定调用哪个版本的虚函数。

- 用

virtual关键字声明: 虚函数使用virtual关键字声明,但不包含=0。

纯虚函数:

- 没有实现:纯虚函数没有函数体,只有函数声明,即没有提供默认的实现。

- 强制覆盖: 派生类必须提供纯虚函数的具体实现,否则它们也会成为抽象类。

- 禁止实例化: 包含纯虚函数的类无法被实例化,只能用于派生其他类。

- 用

=0声明:纯虚函数使用=0在函数声明末尾进行声明。 - 为接口提供规范: 通过纯虚函数,抽象类提供一种接口规范,要求派生类提供相关实现。

1.30 抽象类

抽象类是不能被实例化的类,它存在的主要目的是为了提供一个接口,供派生类继承和实现。抽象类中可以包含普通的成员函数、数据成员和构造函数,但它必须至少包含一个纯虚函数。即在声明中使用 virtual 关键字并赋予函数一个 =0的纯虚函数。

派生类必须实现抽象类中的纯虚函数,否则它们也会成为抽象类

1.31 完美转发(引用折叠+forward)

C++——完美转发(引用折叠+forward) | 爱吃土豆的个人博客

1.32 静态成员变量的初始化位置⭐

- 非模板类的静态成员变量和函数需要在实现文件cpp中初始化,不能在头文件中初始化。因为当该头文件被多个源文件包含时,每个源文件在编译时都会对这个静态成员变量进行定义和初始化,链接时会出现多重定义错误。

1 | // MyClass.h |

- 模板类的静态成员变量必须在头文件中定义,模板类中的静态变量可以在头文件中定义,是因为模板类在编译时不会像普通类那样生成具体的类型和符号。相反,模板类的代码只会在模板被实例化时才生成具体的类型。因此,模板类的静态成员变量不会像普通类的静态成员那样在多个编译单元中重复定义。

1 | // MyClass.h |

constexpr或const整数类型静态成员变量:如果是const整数类型或constexpr静态常量,它们通常是编译时常量,直接在头文件中初始化,避免多次定义。

1 | class MyClass { |

- inline 静态成员变量(C++17 及以上):C++17 引入了

inline关键字,可以在头文件中定义非 const静态成员变量,避免重复定义。

1 | // MyClass.h |

模板的实例化机制:

- 模板的延迟实例化:模板本身并不是一个具体的类或函数,它是一种生成类或函数的蓝图。编译器在遇到模板定义时,并不会立即生成实际的代码,而是在需要使用模板的具体实例时才进行实例化。例如,当你使用

MyTemplate<int>时,编译器才会根据MyTemplate模板生成int类型的具体实例。 - 静态成员变量的实例化:模板类的静态成员变量同样遵循延迟实例化的规则。每个不同的模板实例都会有自己独立的静态成员变量副本(

MyTemplate<int> a和MyTemplate<int> b共享静态成员,但是MyTemplate<double> c中存在另一个静态成员副本,和a、c不共享)。如果将静态成员变量的定义放在.cpp文件中,编译器可能无法在该文件中获取到所有需要的模板实例信息(因为类型有很多,从而导致模板生成的实例也有很多类型,我们只要忽略了其中一种,就有可能导致这种类型的模板实例无法实例化),从而导致某些实例的静态成员变量没有被正确实例化。 - 多重定义问题的特殊性:对于非模板类的静态成员变量,在多个源文件中重复定义会导致链接错误。但对于模板类的静态成员变量,由于每个模板实例的静态成员变量是独立的,不同的模板实例不会导致多重定义问题。只要静态成员变量的定义在每个使用它的翻译单元中都是相同的,就不会出现链接错误。

1.33 移动构造函数什么时候会被自动调用

只有当传入的值为右值时,移动构造函数才会被调用。若传入的值是左值,并且类的拷贝构造函数被显式删除(使用 = delete),那么编译器会直接报错,而不会调用移动构造函数。若传入的右值,编译器会自动调用移动构造函数。

一般来说,

push_back会根据传入值的类型,选择使用拷贝构造函数或者移动构造函数。而std::thread存在移动构造函数,如果push_back不能使用thread的拷贝构造,那为什么不使用移动构造函数呢?

当我们调用push_back 时,传递的对象通常是一个左值(即命名的变量)。如果直接传递左值,编译器会优先尝试调用拷贝构造函数,如果不存在拷贝构造那么会直接报错,而不会调用移动构造,因为thread内部并不会将左值隐式转换为右值,从而调用移动构造。

总结:

- 如果对象的拷贝构造函数可用,但移动构造函数也存在,

push_back会选择合适的构造函数: - 如果传递的是一个左值,会调用拷贝构造函数。

- 如果传递的是一个右值,会调用移动构造函数。

- 如果对象的拷贝构造函数不可用,但移动构造函数存在,

push_back的选择:- 如果传递的是一个左值,会直接报错,编译器无法将左值隐式转换为右值从而调用移动。

- 如果传递的是一个右值,会调用移动构造函数。

1 | std::vector<std::thread> threads; |

1.34 三/五/零法则

三五零法则就是三法则、五法则、零法则。

a. 三法则

三法则规定,如果一个类需要显式定义以下其中一项时,那么它必须显式定义这全部的三项:

- 拷贝构造函数

- 拷贝赋值运算符

- 析构函数

案例说明

根据RAII原则,当类手动管理至少一个动态分配的资源时,通常需要实现上述函数。

1 | class Student { |

在这个示例中,我们有一个Student类手动管理了动态分配的资源(即name),构造函数为name分配内存,析构函数释放分配的内存。但是当Student的对象被复制时会发生什么?

1 | Student s1("Tom", 12); |

当构造s2时,将执行Student的默认拷贝构造函数(因为用户没有显式定义拷贝构造函数)。默认的拷贝构造函数将每个成员进行浅拷贝,这意味着s1.name和s2.name都指向同一块内存。

当main()函数结束时会发生什么?s2的析构函数将被调用,这将释放name所指向的内存,然后s1的析构函数被调用,它将再次尝试释放name指向的内存,但是这块内存已经被释放了!这就导致重复释放内存。

为了避免这种情况,需要提供适当的复制操作:

1 | // 拷贝构造函数 |

拷贝构造函数和拷贝赋值运算符都执行动态分配资源的深拷贝。

b. 五法则

五法则是三法则的扩展。五法则规定,如果一个类需要显式定义以下其中一项时,建议显式定义全部的五项:

- 拷贝构造函数

- 拷贝赋值运算符

- 析构函数

- 移动构造函数

- 移动赋值运算符

因为用户定义(包括=default或=delete)的析构函数、拷贝构造函数或赋值赋值运算符(任意一项),会阻止隐式定义移动构造函数和移动赋值运算符,所以任何想要移动语义的类必须声明全部五个特殊成员函数:

用户显式定义三法则中的任意一项时(包括=default或=delete),会阻止编译器隐式定义移动语义,导致失去优化的机会。该法则只是建议,不做强制要求。

不实现移动语义通常不被视为错误。如果缺少移动语义,编译器通常会尽可能使用效率较低的复制操作。如果一个类不需要移动操作,我们可以轻松跳过这些操作。但是,使用它们会提高效率。

c. 零法则

如果没有显式定义任何特殊成员函数,则编译器会隐式定义所有特殊成员函数(成员变量也会影响隐式定义)。

零法则就是建议优先选择不需要显式定义特殊成员函数的情况。

简单来说,如果类需要管理动态资源(如动态内存、文件句柄、网络连接等)就需要遵循五法则;如果类不需要管理动态资源,那最好不要显式定义析构函数、拷贝/移动构造函数、拷贝/移动赋值运算符。如果类的所有成员都遵循零法则,那么整个类也遵循零法则。 零法则说到底就是建议使用智能指针和其他资源管理工具,以自动处理资源的创建和销毁。这样大多数类都无需直接管理资源,从而可以避免许多常见的资源管理错误,如资源泄漏、重复释放等。通过遵循零法则,开发者可以编写更简洁、更安全的代码。

当有意将某个基类用于多态用途时,可能需要将它的析构函数声明为public和virtual。由于这会阻止生成隐式移动(并弃用隐式复制),因此如果希望保持移动和复制操作的支持,可以显式定义这些操作,或使用 = default 来告诉编译器生成默认的实现。

1 | class base_of_five_defaults |

但是,过多的定义拷贝、移动构造函数/运算符,如果不小心进行对象复制,可能会导致切片现象。切片发生在将派生类对象赋值给基类对象时,导致只保留基类部分,丢失派生类特有的属性和行为。这是因为基类对象不能持有派生类的信息。

这也是为什么多态类经常把复制定义(不是移动)=delete的原因:

- 避免切片:通过将拷贝构造函数和拷贝赋值运算符显式定义为 = delete,可以防止基类对象无意中复制派生类对象,从而避免切片现象。

- 控制对象的生命周期:如果类只应该通过指针或引用来管理,而不是通过值来复制,将复制操作禁用可以更好地控制对象的使用。

比如:

1 | class Base { |

我们可以保留析构、移动构造、移动赋值运算符,将复制构造、复制运算符给delete,避免切片现象。

1.34 std::ref和std::move的区别

a. std::ref

- 功能:

std::ref用于创建一个可拷贝的引用包装器,将给定对象(左值引用,不接受右值引用)作为引用传递给其他需要按值传递的函数,如线程函数。它主要用于在传递引用时避免意外拷,保持对象的原始引用,不会转移所有权。 - 使用场景:在需要将引用传递给 STL 算法、线程或其他需要值拷贝的函数时使用。

thread中便用到了此原理,thread传入的参数若不经过std::ref包装,均会作为右值被保存使用,可以参考文章:

并发编程(1)——线程、thread源码解析 | 爱吃土豆的个人博客

std::ref只是尝试模拟引用传递,并不能真正变成引用,在非模板情况下,std::ref根本没法实现引用传递,只有模板自动推导类型或类型隐式转换时,ref能用包装类型reference_wrapper来代替原本会被识别的值类型,而reference_wrapper能隐式转换为被引用的值的引用类型。 为什么std::ref可以保存参数的引用呢?实现在thread修改参数值,影响到外部传入参数值的效果?

1 | template <class _Ty> |

reference_wrapper是一个类类型,说白了就是将参数的地址和类型保存起来。

1 | _CONSTEXPR20 reference_wrapper(_Uty&& _Val) noexcept(noexcept(_Refwrap_ctor_fun<_Ty>(_STD declval<_Uty>()))) { |

当我们要使用这个类对象时,自动转化为取内部参数的地址里的数据即可,就达到了和实参关联的效果

1 | _CONSTEXPR20 operator _Ty&() const noexcept { |

我们可以这样理解通过 std::ref 传递给 std::thread 构造函数的参数:std::ref 传入的参数会被包装成 std::reference_wrapper 对象,该对象在std::thread 会被改造成右值引用,例如 std::ref(int) 实际是作为 std::reference_wrapper<int> 对象保存在 std::thread 的类成员里。当线程执行时,会触发 std::reference_wrapper 的 operator()(仿函数调用),进而通过这个包装对象获取到外部实参所在地址中的数据,从而实现对外部实参的引用传递。

b. std::move

- 功能:

std::move用于将对象的所有权转移,表示该对象可以被“移动”。它不会执行任何实际的移动操作,而是将对象转换为右值引用,使得可以调用移动构造函数或移动赋值运算符。可以接受左值或右值,对左值使用时将其转换为右值引用,对右值使用仍保持为右值引用

std::ref 关注的是引用的传递,而 std::move 则关注对象的所有权转移

std::move 的行为:

std::move并不执行实际的“移动操作”,而是将对象转化为一个“右值引用”(T&&),提示编译器可以安全地“移动”数据。- 真正的数据移动发生在随后调用的移动构造函数或移动赋值运算符中。

- 一旦使用

std::move,原数据的状态可能会变成“未定义的有效状态”(例如清空容器、将指针置为nullptr等),这会破坏原队列中的数据。

1.35 类型成员和非类型成员

在定义类型别名的时候需要注意,如果定义别名的类型是已知类型,直接加

typedef即可,但对于模板类中嵌套的类型,我们需要额外加typename明确是类型。

1 | //存储元素的类型为pair,由key和value构成 |

比如上面 std::pair 和 std::list 是标准库中的普通模板类,它们本身是已知类型,不需要额外的提示来区分;而bucket_data::iterator 是一个嵌套类型,定义在 bucket_data(即 std::list<bucket_value>)内部,我们需要加 typename 表明它是一个类型,而不是其他可能的非类型成员(数据成员、成员函数、静态成员变量、枚举值)

注意区分类型成员和非类型成员:

- 类型成员是类中定义的类型,主要包括:typedef 或 using 定义的类型别名、嵌套类、模板嵌套类型

- 非类型成员是类的对象或行为,而不是类型定义,主要包括:数据成员(成员变量)、成员函数、静态成员变量、枚举值

1 | class Example { |

为什么需要这样区分?

在模板中,C++ 编译器无法直接区分某个嵌套标识符是 非类型成员 还是 类型成员,因为模板参数可能影响其定义。例如:

1 | template <typename T> |

如果不加 typename,编译器可能认为 T::NestedType 是一个变量或其他非类型成员,而报错。但 T::static_member 是一个非类型成员(静态变量),因此不需要 typename。

当我们对作用域或类重命名时,需要遵循以下规则:

1 | // 因为beast、http、net是作用域,所以可以直接用namespace重命名 |

1.36 左值和右值⭐

- 左值:可以被取地址,可以被修改(除了const修饰的左值),例如变量名或解引用的指针。

- 可以出现在赋值号 = 的左边或右边的表达式,它有一个明确的内存地址,可以被引用或修改。

- 可以绑定到左值引用(

T&)的对象,通常有名字并且可以访问其内存地址。

- 右值:不能被取地址,也不能被修改,例如字面常量、表达式的返回值、函数的(非左值引用)返回值。只能出现在赋值号 = 的右边的表达式,它没有一个明确的内存地址,不能被引用或修改

- 不能直接绑定到左值引用上,但可以绑定到右值引用(

T&&)上

- 不能直接绑定到左值引用上,但可以绑定到右值引用(

但注意,有名字的右值引用变量会被视为左值。

当一个右值引用(如 int&& a)有了名字后,它就成为了一个可以访问的对象,可以通过它来取地址或者修改它的值,因此它满足左值的特征。虽然它最初是绑定到右值的,但它现在作为一个有名字的对象(有名字的变量包括右值引用变量,都是有明确内存地址的),就变成了左值。

1 | // 接受左值引用的函数 |

int&& rref = 10;这里rref是一个右值引用,它绑定到了右值10。- 将右值引用变量视为左值:

processValue(rref);调用processValue函数时,因为rref有名字,编译器会把它当作左值,所以会调用接受左值引用的processValue函数。 - 使用

std::move将其转换为右值:processValue(std::move(rref));通过std::move把rref强制转换为右值,这样就会调用接受右值引用的processValue函数。

1.37 临终值和纯右值⭐

临终值(xvalue)和纯右值(prvalue)都属于右值。

- 纯右值是传统意义上的右值,它是一个不代表任何对象的表达式,通常是字面量、临时对象或者求值结果不与任何对象关联的表达式。纯右值没有标识符,没有持久的内存地址,其生命周期仅限于表达式求值期间。例如:字面量

10、3.14,函数返回的非引用类型结果(如int func() { return 5; }中的func()返回值),以及算术表达式2 + 3等都是纯右值。 - 临终值代表一个对象,该对象的资源(如动态分配的内存)可以被安全地移动,因为这个对象即将结束其生命周期。临终值有一个明确的对象与之关联,但它的资源即将被转移。例如:使用

std::move转换后的对象(std::move(obj))、返回右值引用的函数调用结果(int&& func() { ... }中的func()返回值)都是临终值。

1.38 union 联合体/共用体

- 共用体是一种特殊的类,也是一种构造类型的数据结构。

- 共用体表示几个变量共用一个内存位置,在不同的时间保存不同的数据类型和不同长度的变量。

- 所有的共用体成员共用一个空间,并且同一时间只能储存其中一个成员变量的值。例如如下:

1 | union ChannelManager{ |

一个union 只配置一个足够大的空间以来容纳最大长度的数据成员,以上例而言,最大长度是 double 类型

所以 ChannelManager 的空间大小就是 double 数据类型的大小。在 C++ 里,union 的成员默认属性页为public。union 主要用来压缩空间,如果一些数据不可能在同一时间同时被用到,则可以使用 union。

1.39 C++中的模板全特例化和部分特例化

- 模板全特例化指的是针对某个具体的类型,为模板提供一个完全特化的实现。当使用该特定类型实例化模板时,编译器会优先使用全特例化的版本,而非通用的模板定义。

- 模板部分特例化允许你针对模板参数的某个子集或特定条件,为模板提供一个部分特化的实现。部分特例化只适用于类模板,函数模板不支持部分特例化。

STL 中迭代器的特性萃取用的就是模板特例化。

1.40 move和forward的区别⭐

st::move 的简单实现如下:

1 | template<typename T> |

它首先通过引用折叠将传入的是值折叠为左值引用或右值引用,然后调用 remove_reference<T>::type 移除类型 T 上的引用(如果有的话),无论 T 是左值引用、右值引用,还是非引用类型,remove_reference<T>::type 得到的都是原始的类型。

移除引用后,将该类型强制转换为右值引用(类型是右值引用),以便允许移动语义的优化

1 | template <class _Ty> |

而 std::forward<T>只是单纯的返回一个T&&,但是T的类型需要上层函数传入,如果T是int&,那么返回的其实也是int&;如果T是int&&或者int(右值引用模板参数中,右值会被推断为int,所以这里的int代表右值),返回的其实还是int&&。

std::forward<T>是为了解决传递参数时的临时对象(右值)被强制转换为左值的问题。

参考:C++——完美转发(引用折叠+forward) | 爱吃土豆的个人博客

1.41 C++为什么使用nullptr而不是null⭐

C语言中,NULL通常定义为(void*) 0,C++中NULL一般定义为整型0,这是因为在C语言中,允许void*类型的指针隐式转换为其他类型的指针,而且C语言不支持函数重载。但是

- C++不允许

void*到其他指针的隐式类型转换,若把NULL定义为(void*)0,就无法将其直接赋值给其他类型的指针,这显然不符合空指针常量的使用习惯。 - C++支持函数重载,如果存在两个形参类型是整型和指针的同名重载函数,将NULL传入重载函数时,编译器会选择形参类型的重载函数而不是指针类型的重载函数,因为C++中,NULL通常被定义为整型0。

而 nullptr 是一个空指针常量,类型是std::nullptr_t,可以隐式转换为任意类型的指针,且不会和整数类型产生混淆。

搞明白这两点就明白为什么C可以用#define NULL (void*)0,C++却需要nullptr了。

1.42 在类内定义的函数为隐式的内联函数,即使没有加上inline。而虚函数也可以在类内定义,如何理解内联的虚函数?

- 矛盾点:内联函数是在编译时进行代码展开,要求编译器在编译阶段就确定要调用的函数代码;而虚函数是在运行时根据对象的实际类型动态绑定要调用的函数,这就意味着在编译阶段无法确切知道会调用哪个函数。所以,内联和虚函数的机制在本质上是相互冲突的。

- 实际情况:

- 通过对象调用(静态绑定):当使用对象(而非指针或引用)来调用虚函数时,编译器在编译阶段就能明确对象的具体类型,此时虚函数可以被内联展开。

- 通过指针或引用调用(动态绑定):当使用基类指针或引用调用虚函数时,由于要实现动态绑定,编译器在编译阶段无法确定实际调用的函数,因此虚函数不会被内联。

1.43 volatile如何实现可见性的

当一个变量被声明为 volatile 时,它会保证以下两点:

- 写操作会立即刷新到主内存:线程对

volatile变量进行写操作之后,该变量的新值会马上刷新到主内存,而不是停留在工作内存。 - 读操作会从主内存读取最新值:线程读取

volatile变量时,会直接从主内存读取,而非使用工作内存中的旧值。

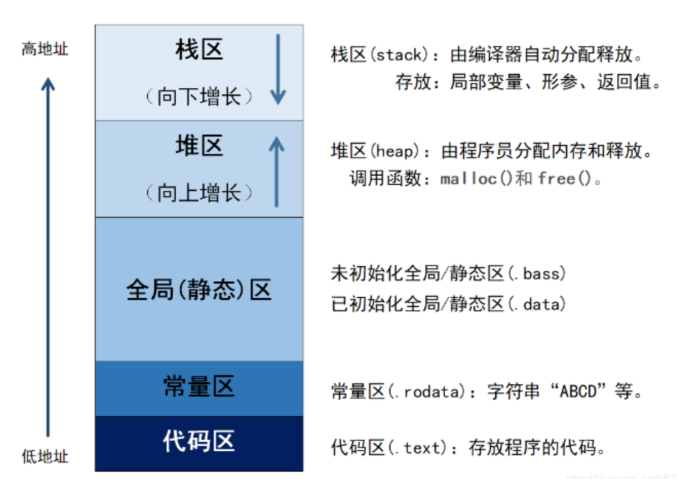

2. 内存

2.1 C++内存分配⭐

C++程序运⾏时,内存被分为几个不同的区域,每个区域负责不同的任务。

- 栈:

- 由编译器管理分配和回收,存放局部变量、形参和返回值。函数的调⽤和返回通过栈来管理 。

- “向下增长” 意味着随着程序中函数调用、局部变量声明等操作,栈区占用的内存空间会朝着内存低地址方向扩展。例如,当一个函数被调用时,其形参和局部变量会依次压入栈中,栈顶指针向低地址移动 。

- 堆:

- 由程序员管理,需要⼿动

new和delete进⾏分配和回收,空间较⼤,但可能会出现内存泄漏和空闲碎片的情况。 - “向上增长” 表示随着程序员不断调用内存分配函数来获取更多内存,堆区占用的内存空间会朝着内存高地址方向扩展。

- 由程序员管理,需要⼿动

- 全局/静态存储区:

- 分为初始化和未初始化两个相邻区域,存储初始化和未初始化的全局变量和静态变量。

- ⽣命周期是整个程序运⾏期间。在程序启动时分配,程序结束时释放

- 内存在程序编译的时候就已经分配好

- 常量存储区:存储常量,⼀般不允许修改。

- 代码区:存放程序的⼆进制代码。

2.2 堆和栈的区别⭐

堆:

- 由程序员手动管理,需通过new delete进行分配和回收,不进行回收会造成内存泄漏。

- 不连续的空间。系统中有一个空闲链表,当有程序申请的时候,系统遍历空闲链表找到第一个大于等于申请大小的空间分配给程序,但频繁的分配和释放内存,可能会导致内存碎片的产生(比如,一开始分配了几个小块内存,后来又释放了其中几块内存,这样就会在已分配的内存之间形成一些小块的空闲空间,这些空闲空间由于不连续,可能无法满足后续较大内存块的分配需求,就像市场中一些摊位被拆除后,剩下的一些小空间无法再容纳大型的摊位一样)

- 从低地址向高地址扩展,访问速度慢(堆上的内存分配和释放是动态的,系统需要花费一些时间来管理这些内存,比如在分配内存时需要查找合适的空闲空间,在释放内存时需要进行一些清理和标记操作)

栈:

由编译器进行管理,在需要时由编译器自动分配空间,在不需要时候自动回收空间,一般保存的是局部变量和函数参数等

连续的内存空间。在函数调用的时候,首先入栈的主函数的下一条可执行指令的地址,然后是函数的各个参数。

大多数编译器中,参数是从右向左入栈(原因在于采用这种顺序,是为了让程序员在使用C/C++的“函数参数长度可变”这个特性时更方便。以

printf这类可变参数函数为例,它需要提前知晓可变参数表中各变量的类型,而第一个参数的作用正是描述这些类型。若从左向右压栈,这个关键参数就会被置于栈底。由于可变参数函数执行的首要步骤是解析可变参数表中各参数的类型,这就意味着一开始就得获取位于栈底的该参数。但栈遵循后进先出原则,栈底元素是最早入栈且最后才能被访问的,想要从栈底获取参数会涉及复杂的栈操作,效率低下且容易出错。所以从右向左压栈,把描述可变参数类型的关键参数放在栈顶附近,函数解析时能更便捷快速地获取,极大简化了可变参数函数的实现与使用 。本次函数调用结束时,局部变量先出栈,然后是参数,最后是栈顶指针最开始存放的地址,程序由该点继续运行,不会产生碎片。

访问速度很快,因为栈上的内存分配是连续的,并且系统对栈的管理非常高效,不需要像堆那样进行复杂的查找和管理操作

栈为什么比堆的效率高

- 内存分配与释放机制

- 栈的内存分配和释放是由系统自动完成的。当进入一个函数时,系统会为该函数的局部变量在栈上分配内存,这些内存是连续的,只需移动栈指针即可完成分配操作,这个过程非常迅速,时间复杂度为 O(1)。

- 堆的内存分配需要程序员手动调用特定的函数(如 C 语言中的

malloc、calloc,C++ 中的new)来完成。操作系统需要在堆空间中寻找合适大小的连续内存块,如果没有足够大的连续内存,还可能需要进行内存碎片整理,这个过程相对复杂,**时间复杂度通常为 O(n)**。

- 内存访问速率

- 栈上的内存是连续分配的,因此 CPU 可以利用缓存机制更高效地访问栈上的数据。当访问栈上的某个数据时,附近的数据也很可能被加载到 CPU 缓存中,从而减少了从内存中读取数据的时间,提高了访问效率。

- 堆上的内存分配是不连续的,容易产生内存碎片。当程序频繁进行堆内存的分配和释放操作时,内存碎片会越来越多,导致 CPU 在访问堆上的数据时,需要花费更多的时间来查找和定位所需的数据,降低了访问效率。

2.3 计算下列类的大小⭐

1 | class A {}; // sizeof(A) = 1 |

对于空类,sizeof(A) 的结果为 1 字节。这是因为在 C++ 里,每个对象都必须有独一无二的内存地址,即便类中没有任何成员变量,编译器也会为其分配至少 1 字节的内存空间,以此保证该类的不同对象能够有不同的地址。

1 | class A{virtual Fun(){} }; // 4或8 |

存在虚函数时,编译器会为这个类创建一个虚函数表(vtable),用于存储该类的所有虚函数的地址。同时,类的每个对象都会包含一个指向虚函数表的指针(vptr)。

- 在 32 位系统中,指针的大小是 4 字节,所以

sizeof(A)为 4 字节。 - 在 64 位系统中,指针的大小是 8 字节,

sizeof(A)则为 8 字节。

1 | class A{static int a; }; // 1 |

静态成员变量属于类本身,而不是类的某个具体对象,它被存储在全局数据区,不占用对象的内存空间。所以,就像空类一样,编译器为对象分配 1 字节的内存,确保其有唯一的地址。

1 | class A{int a; }; // 4 |

在这个类中,只有一个 int 类型的成员变量 a。在大多数系统中,int 类型通常占用 4 字节的内存空间,因此 sizeof(A) 等于 4 字节。

2.4 内存对齐⭐⭐

内存对齐是指将数据存储在特定的内存地址上,使得数据的起始地址是其大小的整数倍(为了方便计算机去读写数据)。

作用:

经过内存对齐之后,CPU 的内存访问速度大大提升。因为 CPU 把内存当成是一块一块的,块的大小可以是2,4,8,16 个字节,因此 CPU 在读取内存的时候是一块一块进行读取的,块的大小称为内存读取粒度。比如说 CPU 要读取一个4个字节的数据到寄存器中(假设内存读取粒度是 4),如果数据是从0字节开始的,那么直接将 0-3 四个字节完全读取到寄存器中进行处理即可

如果数据是从1字节开始的,就首先要将前4个字节读取到寄存器,并再次读取 4-7 个字节数据进入寄存器,接着把0字节,5,6,7字节的数据剔除,最后合并1,2,3,4字节的数据进入寄存器,所以说,当内存没有对齐时,寄存器进行了很多额外的操作,大大降低了CPU的性能。

另外,还有一个就是,有的CPU 遇到未进行内存对齐的处理直接拒绝处理,不是所有的硬件平台都能访问任意地址上的任意数据,某些硬件平台只能在某些地址处取某些特定类型的数据,否则抛出硬件异常。所以内存对齐还有利于平台移植。

原理:

对齐的地址一般都是 n(n = 2、4、8)的倍数。

- 1 个字节的变量,例如 char 类型的变量,放在任意地址的位置上;

- 2 个字节的变量,例如 short 类型的变量,放在 2 的整数倍的地址上;

- 4 个字节的变量,例如 float、int 类型的变量,放在 4 的整数倍地址上;

- 8 个字节的变量,例如 long long、double 类型的变量,放在 8 的整数倍地址上;

结论:

结构体尾部补齐规则:

结构体整体的内存占用需要根据其中最大类型的成员来进行调整。如果结构体中最大类型是像

int这种占 4 个字节的类型,并且结构体的结尾地址不是 4 的倍数,那么需要将结构体的内存空间补齐到离当前结尾地址最近的 4 的倍数地址;若最大类型是像double这种占 8 个字节的类型,且结构体结尾地址不满足 8 的倍数,就需要补齐到离最近的 8 的倍数地址,依此类推。结构体嵌套情况:

当结构体中包含子结构体时,子结构体成员变量的起始地址由子结构体中最大类型的变量决定。例如,若结构体

a包含结构体b,而结构体b中包含char、int、double等元素,那么结构体b应该从 8 的整数倍地址开始存储。具体可参考相关示例。含数组成员的结构体:

如果结构体中包含数组成员,例如

char a[5],其对齐方式等同于连续写 5 个char类型的变量,即按一个字节进行对齐。你可以在多个示例中观察到这种对齐方式。含联合体成员的结构体:

若结构体中包含联合体(

union)成员,联合体的起始地址需要取联合体中最大类型的整数倍地址。相关示例可以帮助你更好地理解这一规则。

举例:

1 | struct stu1 { |

char类型的大小为 1 字节,它的对齐值也是 1 字节,所以a可以从任意地址开始存储,假设其起始地址为 0,则 a[18] 结束的地址为 17;double类型的大小为 8 字节,对齐值为 8 字节,由于a只占 18 字节,若b紧接着c存储,其起始地址为 18,不满足 8 字节对齐要求。因此,编译器会在a后面插入 6个填充字节,使i从地址 24 开始存储,占用 8 个字节(地址 24 - 31);- 然后存储 c,地址为 32;

int类型大小为 4 字节,对齐值为 4 字节,所以会在 c 后补 3 字节,使得 d 从 36 开始存储,36~39;short类型的大小为 2 字节,对齐值为 2 字节。d结束地址是 39,为了满足e的对齐要求,e从地址 40 开始存储,占用 2 字节,地址范围是 40 - 41。- 结构体的对齐值取决于其成员中最大的对齐值,在

struct stu1中,最大对齐值是double类型的 8 字节。当前结构体成员总共占用了 42 字节(18 + 7 + 1 + 3 + 4 + 1 + 2),但为了满足 8 字节对齐,需要在结构体末尾再插入 6 个填充字节,使得结构体总大小为 48 字节。

2.5 智能指针

2.6 野指针和悬浮指针⭐

- 野指针是指指向一个随机的、无效的或者未分配内存地址的指针。这种指针没有被正确初始化,它可能指向任何地方,访问野指针可能会导致程序崩溃、产生不可预期的结果或者引发安全漏洞。

- 产生原因:内存释放后未置空、未初始化(声明指针后没有对其进行初始化赋值,指针的值是随机的)

- 悬浮指针通常是指指针原本指向一个合法的内存地址,但由于该内存被释放或者对象的生命周期结束,导致指针指向的内存不再有效,但指针本身仍然保留着原来的地址值。

- 产生原因:对象生命周期结束(在函数内部定义的对象,当函数执行结束后,对象会被销毁,指向该对象的指针就会变成悬浮指针)

- 解决方法:避免在函数中返回局部变量的引用。使用返回指针或智能指针而不是引用,如果需要在函数之外使用函数内部创建的对象。

2.7 内存模型

并发编程(10)——内存模型、原子操作以及单例模式的三种实现 | 爱吃土豆的个人博客

并发编程(12)——内存次序与内存模型,以及单例模式的三种实现 | 爱吃土豆的个人博客

2.8 类如何实现只能静态分配和只能动态分配 ⭐

在 C++ 里,“类只能静态分配” 意味着该类的对象只能在栈上创建,不能通过 new 运算符在堆上动态分配;“类只能动态分配” 则表示该类的对象只能通过 new 运算符在堆上创建,不能在栈上静态分配。

要让类只能静态分配,也就是禁止在堆上动态分配对象,可通过将类的 new 和 delete 运算符重载为私有成员来达成。因为当 new 和 delete 是私有成员时,外部代码无法调用它们来进行堆上的对象分配和释放操作。

1 | class StaticAllocationOnly { |

要使类只能动态分配,也就是禁止在栈上静态分配对象,可将类的析构函数设为私有成员。由于栈上的对象在其作用域结束时会自动调用析构函数,而私有析构函数外部无法直接调用,所以不能在栈上创建对象。

但注意,析构函数私有之后,我们需要重新定义一个公有的静态成员函数来负责对象的销毁。

2.9 栈溢出的情况有哪些?⭐

栈溢出(Stack Overflow)是指程序在运行过程中,栈空间被耗尽,无法再为新的栈帧分配内存而导致的错误。以下是常见的栈溢出情况:

- 递归调用:比如在AVL树实现插入删除操作时,如果通过递归操作实现,在递归调用的层数超过栈的最大容量时,会导致栈空间被耗尽

- 局部变量占用空间过大:函数的局部变量通常存储在栈上。如果在函数中定义了非常大的局部变量,如大型数组或结构体,会占用大量的栈空间。当多个这样的函数被调用时,栈空间可能会被迅速耗尽,从而导致栈溢出。

- 嵌套函数调用层次过深:每一次函数调用都会在栈上分配一个新的栈帧,当函数调用嵌套层次过多时,栈空间会不断被占用。如果嵌套层次过深,栈空间最终会被耗尽,从而引发栈溢出。

- 线程栈空间过小:每个线程都有自己独立的栈空间,其大小是有限的。如果程序创建了大量的线程,或者某个线程的栈空间设置过小,而该线程又需要执行复杂的操作,可能会导致栈空间不足,从而引发栈溢出。

- 内存碎片问题:虽然栈是连续的内存区域,但在某些情况下,内存碎片可能会影响栈空间的分配。例如,在频繁的内存分配和释放操作后,内存中可能会出现许多不连续的小块空闲内存,当需要为栈帧分配较大的连续内存时,可能会因为找不到足够大的连续内存块而导致栈溢出。一般通过内存池解决内存碎片问题,即STL的一级/二级空间配置器。

解决方法:

- 使用迭代方法替代递归:迭代方法使用循环结构和显式的栈(如

std::stack)来模拟递归调用的过程,将递归调用的状态保存在堆上,从而避免栈溢出。 - 尽量使用引用,或者将参数传入智能指针,智能指针本身存的是对象地址,而指针只占4/8字节,对内存的占用很小

- 线程栈空间太小可手动指定栈大小,或者在线程内尽量使用堆(动态分配而不是编译器分配)

- 内存碎片问题通过内存池解决,或者采用STL空间配置器的思想

2.10 内存泄漏的可能?如何排查?⭐⭐

C++相比于其他语言,内存需要开发者自行申请和释放,如果操作不当就容易造成内存泄漏。导致虚拟内存消耗越来越多,堆内存逐渐被消耗完导致程序崩溃。

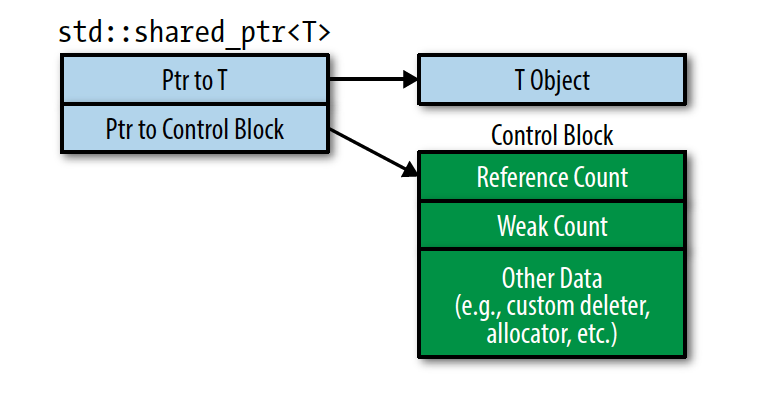

- 分配的内存没有手动释放,可通过智能指针进行管理,对于类对象,可以通过RAII技术

- 智能指针的循环引用,通过引入weak_ptr解决

- 基类的析构函数没有定义成虚函数,举例来说就是,一个基类的指针指向一个派生类的对象,在使用完毕准备销毁时,如果基类的析构函数没有定义成虚函数,那 么编译器根据指针类型就会认为当前对象的类型是基类,调用基类的析构函数 (该对象的析构函数的函数地址早就被绑定为基类的析构函数),仅执行基类的析构,派生类的自身内容将无法被析构,造成内存泄漏。解决方法很简单,基类析构定义为虚函数即可。

出现内存泄漏的主要可能大概是以上三种,但是还有一些特殊的,比如STL内存分配后不会归还堆中,而是归还给STL的空间配置器。我们平常可以使用sTL中的对象代替数组,比如string和vector、array会自行管理内存,可以用来代替数组

如何排查?

- 笨方法,日志。每次分配内存的时候将指针地址打印出来,释放的时候也打印内存,然后再程序结束后,通过分配和释放的差(如果分配的条数大于释放的条数),基本就可以确定出现内存泄漏,然后根据日志的地址进行定位

- 统计,也就是日志的具体实现,创建三个自定义函数,一个用于内存分配,第二个用于内存释放,最后一个用于检查内存泄漏

1 | static unsigned int allocated = 0; |

- 使用工具。在Linux上比较常用的内存泄漏检测工具是

valgrind,所以咱们就以valgrind为工具,进行检测。

我们首先看一段代码:

1 |

|

通过gcc -g leak.c -o leak命令进行编译

执行valgrind --leak-check=full ./leak

在上述的命令执行后,会输出如下:

1 | ==9652== Memcheck, a memory error detector |

valgrind的检测信息将内存泄漏分为如下几类:

definitely lost:确定产生内存泄漏

indirectly lost:间接产生内存泄漏

possibly lost:可能存在内存泄漏

still reachable:即使在程序结束时候,仍然有指针在指向该块内存,常见于全局变量

主要上面输出的下面几句:

1 | ==9652== by 0x40052E: func (leak.c:4) |

提示在main函数(leak.c的第8行)fun函数(leak.c的第四行)产生了内存泄漏,通过分析代码,原因定位,问题解决。

valgrind不仅可以检测内存泄漏,还有其他很强大的功能,由于本文以内存泄漏为主,所以其他的功能就不在此赘述了,有兴趣的可以通过valgrind --help来进行查看

对于Windows下的内存泄漏检测工具,笔者推荐一款轻量级功能却非常强大的工具UMDH,笔者尝试了各种工具(免费的和收费的),最终发现了UMDH,如果你在Windows上进行开发,强烈推荐。

2.11 内存碎片⭐

内存碎片主要分为外部内存碎片和内部内存碎片:

系统中有一个空闲链表,当有程序申请的时候,系统遍历空闲链表找到第一个大于等于申请大小的空间分配给程序,但频繁的分配和释放内存,可能会导致内存碎片的产生(比如,一开始分配了几个小块内存,后来又释放了其中几块内存,这样就会在已分配的内存之间形成一些小块的空闲空间,这些空闲空间由于不连续,可能无法满足后续较大内存块的分配需求,就像市场中一些摊位被拆除后,剩下的一些小空间无法再容纳大型的摊位一样)。虽然整体内存足够,但是无法为较大的内存请求分配连续的内存块,这就是外部碎片。

内部内存碎片是有时分配的内存块大于进程实际需要的内存量,这意味着有一些内存浪费在内部碎片中。

3. C++新特性

3.1 once_flag和call_once⭐

std::call_once 和 std::once_flag 是 C++11 中引入的线程安全的函数和类型,用于确保某个函数只被调用一次。

std::once_flag是一个类型,用于标记一段代码是否已经被执行过。它必须通过引用传递给std::call_once函数,以确保在多线程环境下仅仅执行一次。std::call_once函数接受两个参数:一个可调用对象(可以是函数、lambda 表达式等)和一个std::once_flag对象的引用。该函数会检查std::once_flag对象是否被设置过,如果没有,就调用可调用对象,并设置std::once_flag对象为已设置状态。std::call_once函数充当了加锁的作用,但不用手动操作,函数会自动进行加解锁。

使用 std::call_once 和 std::once_flag 可以避免在多线程环境下多次执行同一个函数,从而提高程序性能和正确性。

1 |

|

在这个例子中,我们定义了一个名为 do_something 的函数,并将其作为参数传递给 std::call_once 函数。 std::once_flag 对象被声明为全局变量,以便在多个线程之间共享。

- 当第一次调用

do_something函数时,std::call_once将检查std::once_flag是否已经被设置过。由于初始状态为未设置,因此std::call_once将执行提供的可调用对象——这里是一个 lambda 表达式,输出一条消息表示函数被调用了一次。 - 当第二次调用

do_something函数时,std::call_once将不再执行提供的可调用对象,因为std::once_flag已经被设置过。

通过这种方式,我们可以确保 do_something 函数中std::call_once 提供的可调用对象被调用一次,无论有多少个线程同时调用它。

1 | do_something() called once |

单例模式有三种实现方式,通过std::call_once和std::once_flag实现便是其中的一种。

3.2 lambda及底层实现机制⭐

lambda表达式是C++11中引入的一项新技术,利用lambda表达式可以编写内嵌的匿名函数,用以替换独立函数或者函数对象,并且使代码更可读。

底层实现原理:

Lambda表达式可以表示闭包,因为C++不像go一样存在闭包操作,但可以通过lambda操作实现伪闭包(底层创建了一个匿名类,该匿名类重载了()运算符,使得该类的对象可以像函数一样被调用,并且将捕获列表中的参数添加至匿名类中,调用 Lambda 表达式时,实际上是调用了闭包对象的operator()方法,该方法可以访问和操作捕获的变量)。

闭包就是能够读取其他函数内部变量的函数。例如在 javascript 中,只有函数内部的子函数才能读取局部变量,所以闭包可以理解成“定义在一个函数内部的函数“。在本质上,闭包是将函数内部和函数外部连接起来的桥梁。这句话里面重点,闭包是一个函数内部的函数,可以读取它所关联函数的局部变量。

1)原型

1 | [capture list] (params list) mutable exception-> return type { function body } |

- capture list:捕获外部变量列表

- params list:形参列表

- mutable指示符:用来说用是否可以修改捕获的变量

- exception:异常设定

- return type:返回类型

- function body:函数体

通常使用以下三种方式省略某写成分来声明不完整的lamba表达式:

1 | // 格式1 |

其中:

- 格式 1 显式指定返回类型

- 格式 2 省略了返回值类型,但编译器可以根据以下规则推断出 Lambda 表达式的返回类型:

- 如果 function body 是完全由一条返回语句组成时(只有return 语句),则该 Lambda 表达式的返回类型由return语句的返回类型确定;

- 如果 function body 中没有 return 语句,则返回值为 void 类型。

- 格式 3 中省略了参数列表,类似普通函数中的无参函数。

1 | auto singleExpressionLambda = [](int x) { return x * 2; }; // 返回类型可以自动推断 |

2)如何使用

1 | // 1 匿名调用 |

上述代码定义了一个匿名函数后直接调用。我们可以通过auto初始化一个变量存储lambda表达式

1 | // 2 通过auto赋值 |

通过auto定义fname,然后存储了lambda表达式,之后调用fname即可。也可以通过函数指针的方式接受lambda表达式

1 | typedef void (*P_NameFunc)(string name); |

定义了一个类型别名 P_NameFunc,它代表一个函数指针,P_NameFunc定义了fname2函数指针接受了lambda表达式。也可以通过function对象接受lambda表达式

1 | // 4 function |

3)lamba的捕获

Lambda 表达式可以使用其作用域内的任何动态变量,但必须明确声明(明确声明哪些外部变量可以被该 Lambda 表达式使用)。那么,在哪里指定这些外部变量呢?Lambda 表达式通过在最前面的方括号 [] 来明确指明其内部可以访问的外部变量,这一过程也称过 Lambda 表达式“捕获”了外部变量。

类似参数传递方式(值传递、引入传递、指针传递),在 Lambda 表达式中,外部变量的捕获方式也有值捕获、引用捕获、隐式捕获。

1.值捕获

1 | // 1.值捕获 |

上述lambda表达式捕获了age和name,是以值的方式来捕获的。所以无法在lambda表达式内部修改age和name的值,如果修改age和name,编译器会报错,提示无法修改const常量,因为age和name是以值的方式被捕获的。

2.引用捕获

1 | int age = 33; |

[]里age和name前边添加了&,此时age和name是以引用方式捕获的。所以可以在lambda表达式中修改age和name的值。

C++的lambda表达式虽然可以捕获局部变量的引用,达到类似闭包的效果,但不是真的闭包,golang和python等语言通过闭包捕获局部变量后可以增加局部变量的声明周期,C++无法做到这一点,所以下面的调用会出现崩溃(C++可以通过智能指针实现伪闭包)。

1 | vector<function<void(string)>> vec_Funcs; |

use_lambda2中将lambda表达式存储在function类型的vector里,当use_lambda2结束后,里边的局部变量都被释放了,而vector中的lambda表达式还存储着局部变量的引用,在调用use_lambda3时调用lambda表达式,此时访问局部变量已经被释放了,所以导致程序崩溃。

但如果将传入的参数通过智能指针指向,并将智能指针作为形参传入函数,那么智能指针内部的引用计数会自动加减,防止局部变量被提前释放导致程序崩溃(可以参考C++服务器中的伪闭包操作)

3. 全部用值捕获,name用引用捕获

1 | int age = 33; |

通过=表示所有变量都以值的方式捕获,如果希望某个变量以引用方式捕获则单独在这个变量前加&

- 全部用引用捕获,只有name用值捕获

1 | int age = 33; |

通过&方式表示所有变量都已引用方式捕获,如果希望某个变量以值方式捕获则单独在这个变量前加=。

总结:

- [] 不捕获任何外部变量

- [变量名, …] 默认以值的形式捕获指定的多个外部变量(用逗号分隔),如果引用捕获,需要显示声明(使用 & 说明符)

- [=] 值捕获,捕获所有外部变量,在函数内有个副本使用

- [&] 引用捕获,捕获所有外部变量,在函数体内当作引用使用

- [=, &x] 值捕获所有外部变量,只按引用捕获 x 变量

- [&, =x] 引用捕获所有外部变量,只按值捕获 x 变量

- [this] 捕获当前类中的 this 指针。如果已经使用了 & 或者 = ,无需显式写出

[this],编译器会自动捕获this指针,方便在 Lambda 函数体中访问类的成员

3.3 std::function⭐

std::function是从c++11开始支持的特性,使用它需要包含<functional>头文件

在cppreference中解释为:类模板 std::function 是一个通用的多态函数包装器。std::function的实例可以对任何可以调用的目标实体进行存储、复制、和调用操作,这些目标实体包括

- 函数

- 函数指针

- lambda 表达式

- bind 创建的对象

- 重载了函数调用运算符的类(仿函数)

std::function可以绑定全局函数,静态函数,但是绑定类的成员函数时,必须要借助std::bind的帮忙

它不能被用来检查相等或者不相等,但是可以与 NULL 或者 nullptr 进行比较

通俗的来说可以把它当做一个函数指针来使用

1)如何使用

function的模板是 std::function<返回值类型(传入参数类型)> 方法名

1 | typedef std::function<void(std::shared_ptr<CSession>, const short& msg_id, const std::string& msg_data)> FunCallBack; |

这里我定义了一个名为 FunCallBack 的函数指针,它传入的参数类型: 1)std::shared_ptr<CSession> 实现伪闭包,防止目标被提前释放;2)constshort& msg_id,用于存储消息id;3)const std::string& msg_data 用于存储消息内容;返回类型为void。

1 | std::map<short, FunCallBack> _fun_callback; |

其中,HelloWordCallBack是_fun_callback类型的函数指针,被bind绑定于_fun_callback[MSG_HELLO_WORD]中,对应的键MSG_HELLO_WORD会触发对应的值HelloWordCallBack。

3.4 std::bind

std::bind将原函数的几个参数通过bind绑定传值,返回一个新的可调用对象,也就是改造现有函数,生成新的函数。

比如我现在需求,我要一个有 2 个 int 类型参数的函数,并且第二个参数默认为 2。你可千万不要屁颠屁颠的在去写一个f(int i, int i = 2),这里std::bind的作用体现出来了,看:

1 | int f(int a, int b); |

然后将bind的返回值交给function,定义函数原型fun如下

1 | std::function<int(int,int)> fun = std::bind(&f, std::placeholders::_1, 2); |

注:1)std::bind返回后的函数和原函数是完全不同的函数,他们的内存地址完全不同

2)bind中的‘&’都是取址符不是引用

在使用 std::bind 绑定可调用对象时,有时加 & 有时不加,这主要取决于可调用对象的类型:

- 对于普通函数,加

&和不加&效果是一样的。因为函数名在大多数情况下会隐式转换为函数指针。 - 对于成员函数,必须加

&。因为成员函数指针和普通函数指针不同,它需要明确指出是成员函数的指针,不能通过隐式转换得到。 - 对于仿函数,通常不加

&。仿函数是一个重载了()运算符的类的对象,它本身就是一个可调用对象,不需要取地址。

1)如何使用

std::bind函数定义在头文件<functional>中,std::bind 可以将可调用对象和参数一起绑定,绑定后的结果使用std::function进行保存,并延迟调用到任何我们需要的时候,所以经常用来实现回调函数。

std::bind的作用:

- 将可调用对象与参数一起绑定为另一个

std::function供调用 - 将 n 元可调用对象转成 m(m < n) 元可调用对象,绑定一部分参数,这里需要使用

std::placeholders

2)原型

1 | template <class Fn, class... Args> |

模板1:

- 基于参数

fn返回一个函数对象,并且以args参数绑定为函数对象的参数。 - 每个参数要么绑定一个参数值,要么绑定为一个

std::placeholders(占位符,如 _1, _2, …, _n)。 - 如果参数绑定成一个值,那么返回的函数对象将总使用绑定的参数值做为调用参数,即调用传入参数将不起作用;如果参数绑定为

std::placeholders,那么返回的函数对象在被调用时需要传入实时参数,参数填充的位置即由placeholder指定的序号。

模板2:

fn:可调用的函数对象,比如函数对象、函数指针、函数引用、成员函数或者数据成员函数。args:需要绑定的函数的参数列表,使用命名空间占位符std::placeholders::_1,std::placeholders::_2标志参数,其中std::placeholders::_1标志为参数列表中的第一个参数,std::placeholders::_2标志参数列表中的第二个参数,std::placeholders::_3标志参数列表中的第三个参数,以此类推。

3)举例

1 | //绑定全局函数 |

placeholders表示占位符,_1表示新生成函数的第一个参数, _2表示新生成函数的第二个参数,将这些参数传递给原函数达到占位的效果,原函数的其余参数通过bind绑定固定值。

接下来定义类

1 | class BindTestClass |

成员函数实现:

1 | void BindTestClass::StaticFun(const string &str, int age) |

使用bind绑定静态成员函数

1 | //绑定类的静态成员函数,加不加&都可以 |

新生成的staticbind函数可以直接传递一个参数zack就完成了调用。接下来用bind绑定成员函数(这里是&都是取地址而不是引用)

1 | BindTestClass bindTestClass(33, "zack"); |

也可以用function对象接受bind返回的结果

1 | // function接受bind返回的函数 |

3.5 condition_variable

并发编程(5)——条件变量、线程安全队列 | 爱吃土豆的个人博客

3.6 右值引用

在前面已经介绍过了,这里主要说明右值引用的两大作用:

- 完美转发

- 移动语义,通过移动构造函数和移动赋值运算符,可以将临时对象的资源高效地转移到新对象中,避免不必要的拷贝。

参考:C++——完美转发(引用折叠+forward) | 爱吃土豆的个人博客

3.7 智能指针

前文已介绍

3.8 auto和decltype ⭐

auto可以让编译器在编译期就推导出变量的类型

- auto的使用必须马上初始化,否则无法推导出类型

- auto在一行定义多个变量时,各个变量的推导不能产生二义性,否则编译失败

- auto不能用作函数参数(可用模板参数代替)

- 在类中auto不能用作非静态成员变量

- auto不能定义数组,可以定义指针

- auto无法推导出模板参数

- 在不声明为引用或指针时,auto会忽略等号右边的引用类型和cv限定

- 在声明为引⽤或者指针时, auto会保留等号右边的引⽤和cv属性

decltype获取一个表达式的类型,而不对表达式进行求值(类似于sizeof)。

decltype不会像auto一样忽略引用和cv属性,decltype会保留表达式的引用和cv属性

对于decltype(exp)有:

- exp是表达式,decltype(exp)和exp类型相同

- exp是函数调用,decltype(exp)和函数返回值类型相同

- 若exp是⼀个纯右值,则返回值为

T - 若 e 是⼀个临终值,则返回值为

T&&

1 | int num = 10; |

3.9 泛化的常量表达式

1 | int N = 5; |

该段代码是错的,N是一个变量,我们不能使用一个变量来为数组开辟一个确定大小的空间,因为这个变量的值随时都可以变,不能用做一个确定的对象。我们需要声明为 const int N = 5 才可以 。

我们也可以通过泛化常数来解决:

1 | constexpr int N = 5; // N |

constexpr 告诉编译器这是⼀个编译期常量,甚至可以把一个函数声明为编译期常量表达式。

1 | constexpr int getFive(){ return 5; } |

3.10 nullptr

nullptr是用来代替NULL,一般C++会把NULL、0视为同一种东西,这取决去编译器如何定义NULL,有的定义为((void&)0),有的定义为0.

C++不允许直接将void*隐式转换到其他类型,在进行C++重载时会发生混乱。

比如,我们想要重载 foo 函数:

1 | void foo(char *); |

在代码中使用 NULL 时会出现一些问题。在某些实现里,NULL 被定义为 ((void*)0) 。当我们编写 char *ch = NULL; 这样的代码时,NULL 实际上会被当作 0 来处理。而当调用 foo(NULL) 时,由于此时 NULL 等同于 0,编译器会选择调用 foo(int) 这个重载版本,这就可能导致代码的行为与预期不符,产生混淆。

为了解决这个问题,C++11 引入了 nullptr 关键字。nullptr 的出现是为了清晰地区分空指针和整数 0。nullptr 的类型是 nullptr_t,它具有很好的兼容性,能够隐式转换为任何指针类型或者成员指针类型。同时,nullptr 也可以进行相等或不等的比较操作。所以,在需要使用空指针的场景下,建议用 nullptr 来替代 NULL,这样可以避免因 NULL 带来的类型匹配歧义问题。例如,调用 foo(nullptr) 时,编译器会明确地将 nullptr 当作空指针来处理,从而调用 foo(char *) 版本的函数,让代码的行为更加明确和可预期。

3.11 并行

并行也是C++11新特性,包括std::thread、std::async、std::future以及各种锁。

4. STL容器

4.1 基础知识

4.1.1 什么是STL,包含哪些组件

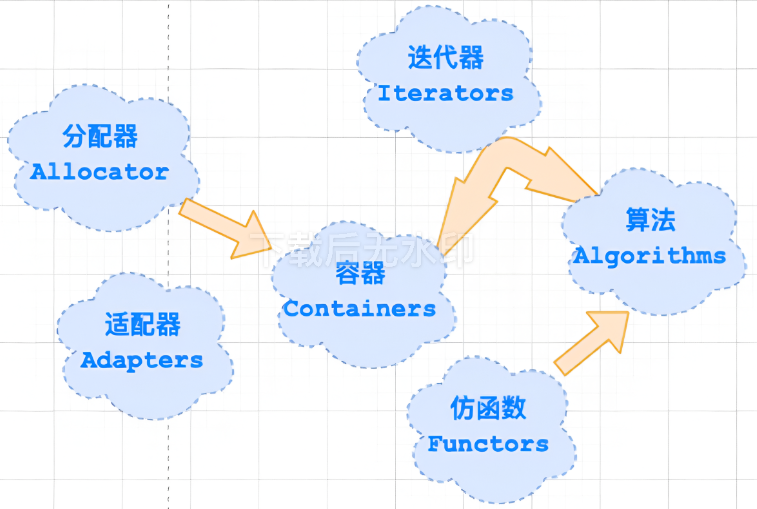

广义上讲,STL分为3类:Algorithm(算法)、Container(容器)和lterator(迭代器),容器和算法通过迭代器可以进行无缝地连接。

详细的说,STL由6部分组成:容器(Container)、算法(Algorithm)、迭代器(lterator)、仿函数(Functionobject)、适配器(Adaptor)、空间配制器(Allocator)。

STL六大组件的交互关系:

- 容器通过空间配置器取得数据存储空间

- 算法通过迭代器存储容器中的内容

- 仿函数可以协助算法完成不同的策略的变化

- 适配器可以修饰仿函数。

STL六大组件的介绍:

容器:各种数据结构,如

vector、list、deque、set、map等,用来存放数据,从实现角度来看,STL容器是一种模板类。算法:各种常用的算法,如

sort、find、copy、for_each。从实现的角度来看,STL算法是一种模板函数。迭代器:扮演了容器与算法之间的胶合剂,共有五种类型,从实现角度来看,迭代器是一种将

operator*,operator->,operator++,operator-等指针相关操作予以重载的模板类。所有STL容器都附带有自己专属的迭代器,只有容器的设计者才知道如何遍历自己的元素。原生指针(

int*、double*)也是一种迭代器。仿函数:行为类似函数,可作为算法的某种策略。从实现角度来看,仿函数是一种重载了

operator()的class 或者classtemplate适配器:一种用来修饰容器或者仿函数或迭代器接口的东西。STL提供的

queue和stack,虽然看似容器,但其实只能算是一种容器配接器,因为它们的底部完全借助deque,所有操作都由底层的deque供应。空间配置器:负责空间的配置与管理。从实现角度看,配置器是一个实现了动态空间配置、空间管理、空间释放的模板类。一般的分配器的

std:alloctor都含有两个函数allocate与deallocte,这两个函数分别调用operator new()与delete(),这两个函数的底层又分别是malloc(and free();但是每次maloc会带来格外开销

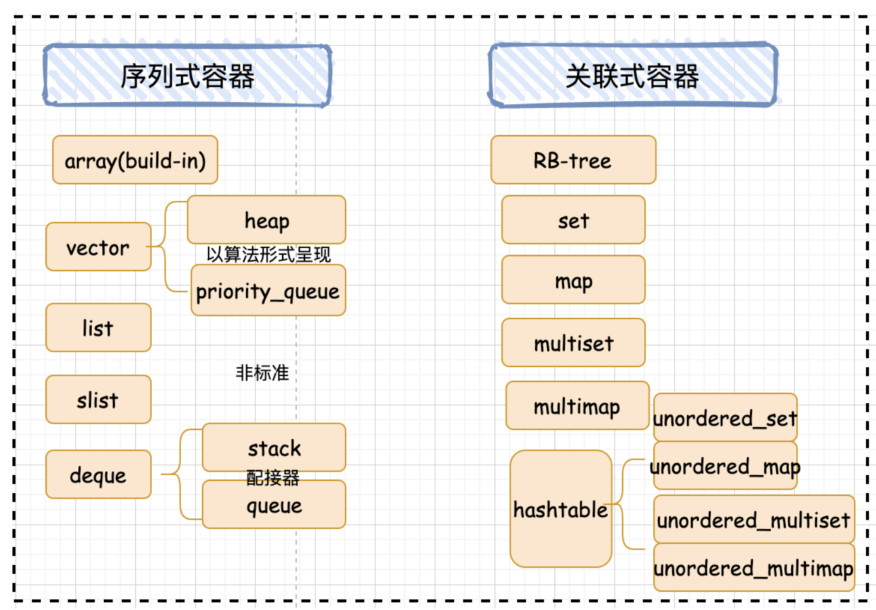

4.1.2 常见的容器

STL容器分为序列式容器和关联式容器,如下图所示:

序列容器:

vector(向量):

std::vector是一个动态数组实现,提供高效的随机访问和在尾部进行插入/删除操作。是动态空间,随着元素的加入,它的内部机制会自行扩充空间以容纳新元素。vector 维护的是一个连续的线性空间,而且普通指针就可以满足要求作为vector的迭代器。扩充的过程并不是直接在原有空间后面追加容量,而是重新申请一块连续空间,将原有的数据拷贝到新空间中,再释放原有空间,完成一次扩充。需要注意的是,每次扩充是重新开辟的空间,所以扩充后,原有的迭代器将会失

list(链表):

std::list是一个双向链表实现,支持在任意位置进行插入/删除操作,但不支持随机访问。与 vector 相比,list 的好处就是每次插入或删除一个元素,就配置或释放一个空间,而且原有的迭代器也不会失效。list 是一个双向链表,普通指针已经不能满足 list 迭代器的需求,因为 list 的存储空间是不连续的。list 的迭代器必需具备前移和后退功能,所以list 提供的是 Bidirectionallterator。list 的数据结构中只要一个指向 node节点的指针就可以了。

deque(双端队列):

std::deque是一个双端队列实现,允许在两端进行高效插入/删除操作。vector 是单向开口的连续线性空间,deque 则是一种双向开口的连续线性空间。所谓双向开口,就是说 deque 支持从头尾两端进行元素的插入和删除操作。相比于 vector 的扩充空间的方式,deque 实际上更加贴切的实现了动态空间的概念。deque 没有容量的概念,因为它是动态地以分段连续空间组合而成,随时可以增加一段新的空间并连接起来,代价是复杂的迭代器结构,除非必要,应该尽可能的使用 vector。

array(数组):

std::array是一个固定大小的数组实现,提供对数组元素的高效随机访问。forward_list(前向链表):

std::forward 1ist是一个单向链表实现,只能从头到尾进行遍历,不支持双向访问。

关联容器:

- set(集合):

std::set是一个有序的集合,不允许重复元素,支持快速查找、插入和删除。 - multiset(多重集合):

std::multiset是一个有序的多重集合,允许重复元素。 - map(映射):

std::map是一个有序的键值对集合,不允许重复的键,支持快速查找、插入和删除。 - multimap(多重映射):

std::multimap是一个有序的多重映射,允许重复的键。 - unordered set(无序集合):

std::unordered set是一个无序的集合,不允许重复元素,支持快速查找、插入和删除。 - unordered multiset(无序多重集合):

std::unordered multiset是一个无序的多重集合,允许重复元素。 - unordered map(无序映射):

std::unordered map是一个无序的键值对集合,不允许重复的键,支持快速

查找、插入和删除。 - unordered_multimap(无序多重映射):

std::unordered multimap是一个无序的多重映射,允许重复的键。

容器适配器:虽然它不是容器,但它底层是依靠容器实现的

stack(栈):

std::stack是一个基于底层容器的栈实现,默认使用std::deque。是一种先进后出的数据结构,只有一个出口,stack 允许从最顶端新增元素,移除最顶端元素,取得最顶端元素。deque 是双向开口的数据结构,所以使用 deque 作为底部结构并封闭其头端开口,就形成了一个 stack。

queue(队列):

std::queue是一个基于底层容器的队列实现,默认使用std::queue。是一种先进先出的数据结构,有两个出口,允许从最底端加入元素,取得最顶端元素,从最底端新增元素,从最顶端移除元素。deque 是双向开口的数据结构,若以 deque 为底部结构并封闭其底端的出口,和头端的入口,就形成了一个 queue。(其实 list 也可以实现 deque)

priority_queue(优先队列):

std::priority_queue是一个基于底层容器的优先队列实现,默认使用std::vector。priority_queue允许用户以任何次序将任何元素推入容器内,但取出时一定是从优先权最高(数值最高)的元素开始取。

4.1.3 迭代器⭐

4.1.3.1 型别和类别

迭代器相应型别有 5 种:

value_type:迭代器所指对象的类型,原生指针也是一种迭代器,对于原生指针int*,int即为指针所指对象的类型,也就是所谓的value_typedifference_type:用来表示两个迭代器之间的距离,对于原生指针,STL以C++ 内建的ptrdiff_t作为原生指针的difference_type。reference_type:是指迭代器所指对象的类型的引用,reference_type一般用在迭代器的*运算符重载上,如果value_type是T,那么对应的reference_type就是T&;如果value_type是const T,那么对应的reference_type就是const T&。pointer_type:就是相应的指针类型,对于指针来说,最常用的功能就是operator*和operator->两个运算符。iterator_category:的作用是标识迭代器的移动特性和可以对迭代器执行的操作,从iterator_category可将选代器分为 Inputlterator、Output lterator、Forward lterator、Bidirectional lterator、RandomAccess lterator五类

1 | template<typename Category, |

iterator class 不包含任何成员变量,只有类型的定义,因此不会增加额外的负担。由于后面三个类型都有默认值,在继承它的时候,只需要提供前两个参数就可以了。 这个类主要是⽤来继承的,在实现具体的迭代器时,可以继承上面的类,这样子就不会漏掉上面的 5 个型别了。

迭代器型别 iterator_category 对应有 5 个类别:

- 输入迭代器

Input Iterator:此迭代器不允许修改所指的对象,是只读的。支持 ==、!=、++、*、->等操作 - 输出迭代器

Output Iterator:允许算法在这种迭代器所形成的区间上进行只写操作。支持 ++、*等操作。 - 前向迭代器

Forward Iterator:允许算法在这种迭代器所形成的区间上进行读写操作,但只能单向移动,每次只能移动一步。支持Input lterator和Output lterator的所有操作。 - 双向迭代器

Bidirectional Iterator:允许算法在这种迭代器所形成的区间上进行读写操作,可双向移动,每次只能移动一步。支持Forward lterator的所有操作,并另外支持-操作。 - 随机访问迭代器

Random Access Iterator:包含指针的所有操作,可进行随机访问,随意移动指定的步数。支持前面四种lterator的所有操作,并另外支持[n]操作符等操作。

大部分容器都有 begin() 和 end() 两个成员函数,begin() 用于返回指向容器第一个元素的迭代器,而 end() 返回指向容器最后一个元素的下一个位置的迭代器,即超尾。

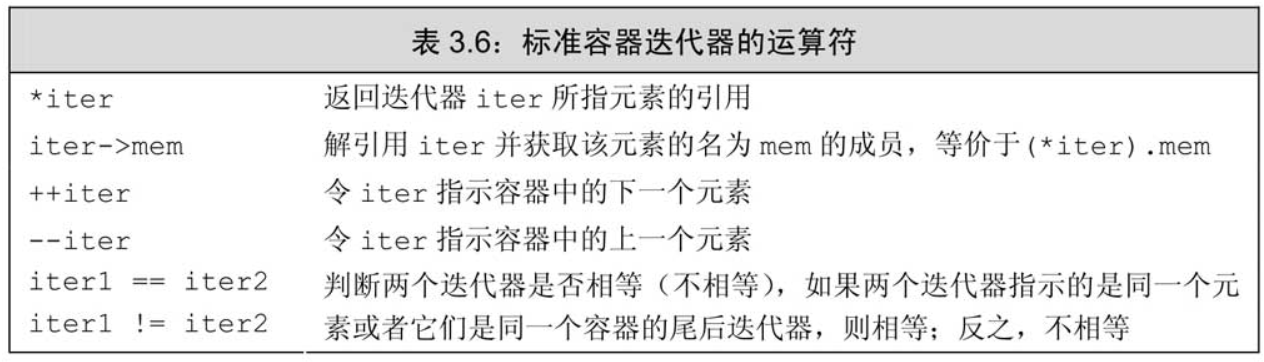

迭代器常用的操作如下:

4.1.3.2 简单使用

a) 引用容器迭代器

我们定义容器的迭代器一般通过容器的iterator和const_iterator来表示迭代器的类型:

1 | // 迭代器it, it能读写vector<int>的元素 |

begin() 和 end() 返回的具体类型由对象是否是常量决定,如果对象是常量,begin和end返回const_iterator;如果对象不是常量,返回iterator:

1 | std::vector<int> v; |

b) 结合解引用和成员访问操作

解引用迭代器可获得迭代器所指的对象,如果该对象的类型恰好是类,就有可能希望进一步访问它的成员。例如,对于一个由字符串组成的vector对象来说,要想检查其元素是否为空,令it是该vector对象的迭代器,只需检查it所指字符串是否为空就可以了,其代码如下所示:

1 | (*it).empty() |

(*it).empty()中的圆括号必不可少,该表达式的含义是先对it解引用,然后解引用的结果再执行点运算符。也可以用 it->empty() 代替/

1 | std::vector<std::string> vs = {"hello", "world"}; |

为了简化上述表达式,C++语言定义了箭头运算符(->)。箭头运算符把解引用和成员访问两个操作结合在一起,也就是说,it->mem和(*it).mem表达的意思相同。

4.2 面试知识

4.2.1 push_back和emplace_back

push_back 和 emplace_back 是 C++ 标准库容器(如 std::vector、std::list、std::deque 等)提供的用于在容器尾部添加元素的成员函数。

push_back:

- 当使用

push_back时,需要先在容器外部创建一个对象,然后将这个对象传递给push_back函数。如果传递的是左值,会调用拷贝构造函数将对象复制到容器中;如果传递的是右值,会调用移动构造函数将对象移动到容器中。相当于连续创建了两个内容相同但地址不同的对象,一个在外部用于给容器提供拷贝构造或赋值运算符的参数对象,一个在内部。 - 在添加对象时可能会涉及到拷贝或移动操作,尤其是对于大型对象,这些操作会带来一定的性能开销。可能会因为内存不够而抛出异常。

emplace_back:

emplace_back会直接在容器的内存空间中调用对象的构造函数进行对象的构造,它接收构造对象所需的参数,然后在容器内部原地构造对象,避免了不必要的拷贝或移动操作。- 由于直接在容器内部构造对象,避免了拷贝或移动操作,因此在性能上通常更优,特别是对于需要动态分配内存的对象。且因为容器内部已经开辟好内存了,不会因为内存原因抛出异常。

举例:

1 | class MyClass { |

- 使用

push_back添加左值:先创建对象obj,然后调用push_back时会调用拷贝构造函数将obj复制到容器中。 - 使用

push_back添加右值:直接传递临时对象MyClass(2, "World")给push_back,会调用移动构造函数将临时对象移动到容器中。 - **使用

emplace_back**:直接传递构造对象所需的参数3和"C++"给emplace_back,它会在容器内部原地调用构造函数构造对象,不会触发拷贝或移动构造函数。

4.2.2 resize() 和 reserve()⭐

可以使用 resize、reserve、shrink_to_fit 调整向量的大小

1 | // 辅助函数,用于输出 vector 的大小和容量 |

resize(count)改变std::vector中的元素数量,如果不指定元素值会默认添加 0- 若

count大于当前大小,会在容器末尾添加新元素,可能会导致内存重新分配。 - 若

count小于当前大小,会移除容器末尾的元素,不会改变容量。

- 若

reserve(new_cap )为std::vector预留一定的内存空间,改变容器的容量,但不会改变容器中元素的数量,数量仍旧是之前的- 若

new_cap大于当前容量,会重新分配内存,将原有元素复制(或移动)到新的内存空间,释放旧内存,容器容量变为new_cap - 若

new_cap小于或等于当前容量,不会进行内存重新分配,容器容量保持不变。

- 若

shrink_to_fit用于释放多余的内存,使容器的容量尽可能接近当前大小

注意:reserve() 是改变容器容量,而 reverse() 是颠倒容器元素

4.2.3 STL 迭代器的原理(特性萃取 iterator_traits)⭐⭐

迭代器其实也是一种智能指针(模板类),重载了一些运算符(如 *、->、++、-- 等),使得迭代器在使用上类似于普通指针,但它可以完成更复杂的操作,主要是一种统一的接口来遍历和操作各种不同容器中的元素。

主要难点其实在于如何成为一个共用的工具?迭代器是如何判断其所指对象的类型是什么的,从而获取迭代器操作的算法的返回类型?(迭代器可以用于不同类型的容器,我们无法提前知道具体的类型,这就给确定返回类型带来了困难)

主要步骤是:函数模板的参数推导机制(但是无法返回函数类型只能是void或者非推导参数类型,因为我们不能提前知道推导的类型,自然返回类型也不能提前指定了,虽然可以通过auto加尾置返回类型解决,但我们的重心不在于这个)->类内嵌类型声明(虽然在类中可以为所指对象的类型定义别名,然后在模板函数中将该类传入,然后使用这个类定义的别名作为返回类型,但是如果传入给函数模板的是一个原始指针int*,那么就没办法了,int*可不是一个类,自然也没办法声明一个内嵌类型)->模板偏特化(通过一层类封装,使得传入模板函数的类或原始指针先进入一个封装类,在这个封装类中声明所指对象的类型的别名,然后将封装类中定义的类型别名作为模板参数返回类型即可)。

1 | // 封装类模板 |

这样,不同算法的返回类型就是迭代器,我们通过将一个迭代器(原生指针也是迭代器)传入算法中,然后将传入模板函数的类或原始指针先放入一个封装类中,在这个封装类中声明所指对象的类型的别名,然后将封装类中定义的类型别名作为模板参数返回类型。

原理可参考:手撕 STL 迭代器源码与 traits 编程技法

4.2.4 空间配置器(malloc 底层实现原理)⭐⭐

该问题也可以理解为:**

malloc底层实现原理**

在这之前我们需要明白 new/delete 时,编译器做了什么操作?

在C++中,当我们调用 new/delete 运算符进行对象创建、销毁以及内存分配、释放时,通常包含以下两阶段操作:

- 对

operator new来说,编译器首先会调用底层的库函数malloc()进行内存分配,然后调用对象的构造函数进行对象内容的构造 - 对

operator delete来说,编译器首先会调用对象的析构函数进行对象内容的销毁,然后调用底层库函数free()进行内存的释放

但是在 STL allocator 中,上面的两点四步骤被分为了四个函数:

- 对象构造由

::construct()负责; - 对象释放由

::destroy()负责; - 内存配置由

alloc::allocate()负责; - 内存释放由

alloc::deallocate()负责

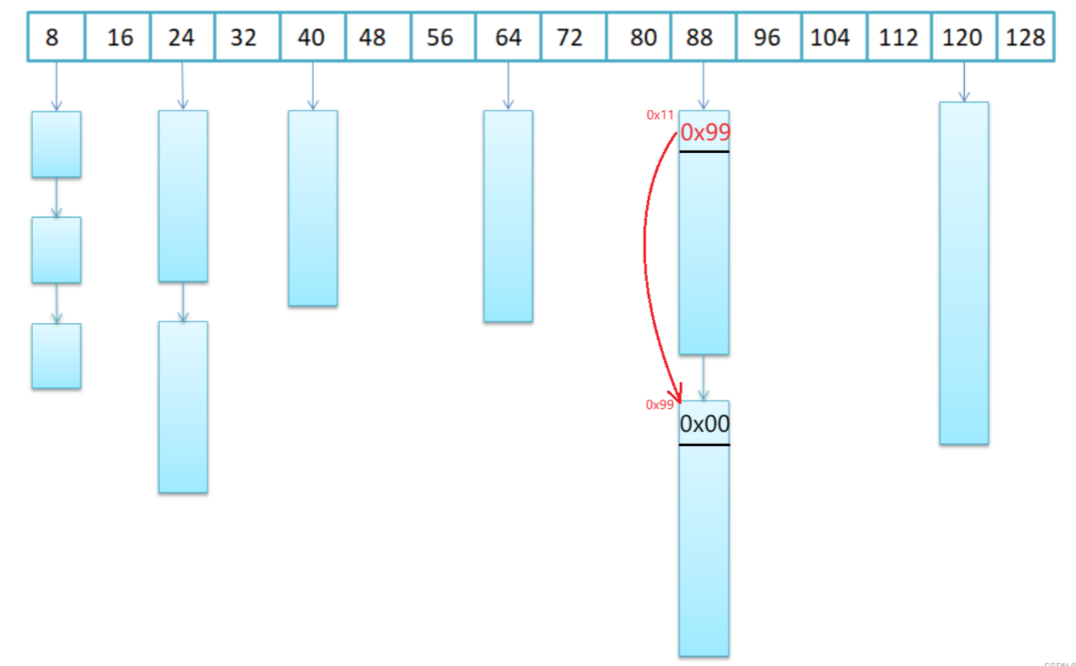

在STL中,为了高效地为容器进行空间管理,并且防止频繁向系统申请小块内存而造成内存碎片、影响程序运行效率,STL 建立了空间配置器为容器进行空间配置。

考虑到频繁向系统申请小块内存而造成内存碎片的问题,STL 空间配置器被分为了两类:

- 当配置区块超过 128 字节时,使用一级配置器,直接使用

malloc()和free()。如果一级配置器的内存也不够,会直接调用oom_malloc(),其实该函数内部只不过是不断循环进行对象的配置释放、以期有一次因为其他对象的释放而使得本次操作能分配成功。 - 当配置区块不大于 128 字节时,使用二级配置器,采用内存池进行内存分配。

内存池其实就是先申请一块比较大的内存块已做备用,当需要内存时,直接到内存池中去取,当池中空间不够时,再向内存中去取,当用户不用时,直接还回内存池即可。避免了频繁向系统申请小块内存所造成的效率低、内存碎片以及额外浪费的问题。

内存池中的空间是以哈希桶结构管理的,这里的哈希桶是以 8 字节 的 整数倍 进行设置的, 如果用户所需内存块不是8的整数倍,向上对齐到8的整数倍。原因有两个:

- 因为用户申请的空间基本都是4的整数倍,其他大小的空间几乎很少用到。

- 每个桶下面悬挂一个个的未被分配的空间,每个未被分配的内存块的首部(前 4 或 8 个字节)会存储下一个未分配内存块的地址(如果没有下一个内存块则存储

nullptr),而32位下指针是 4 字节, 64 位系统下的地址是 8 字节。

首部地址其实是用 union 联合体存储的,以便节省空间。

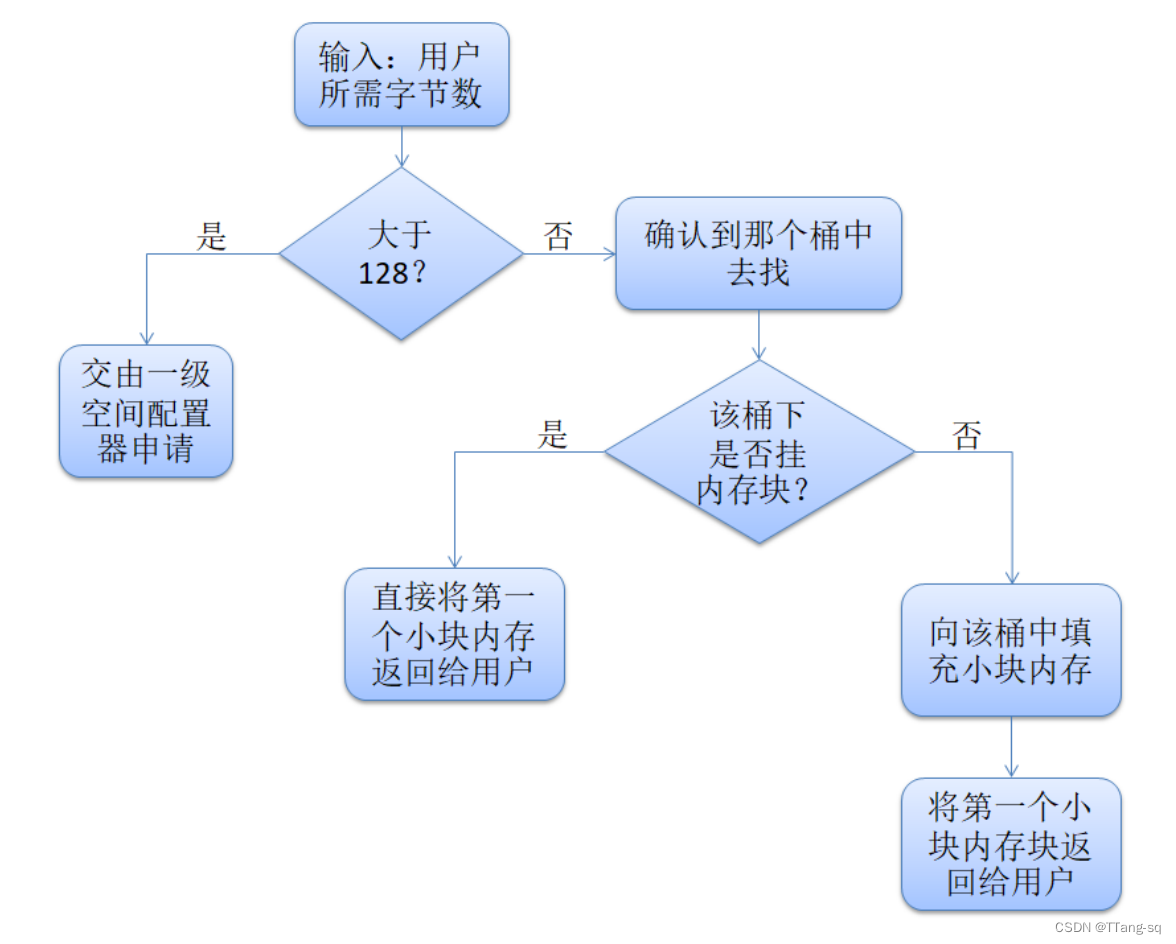

二级配置器的空间申请流程:

- 如果配置空间大于 128 字节,使用 一级 allocator 进行分配

- 若配置空间 小于 128 字节且不是 8 的倍数,则将其上升至 8 的倍数去找相应大小的桶,如果下面有悬挂内存,就把第一个给用户

- 如果桶下没有内存,去找内存池索要(调用

refill()函数从内存池中取),并将第一个内存块返回给用户

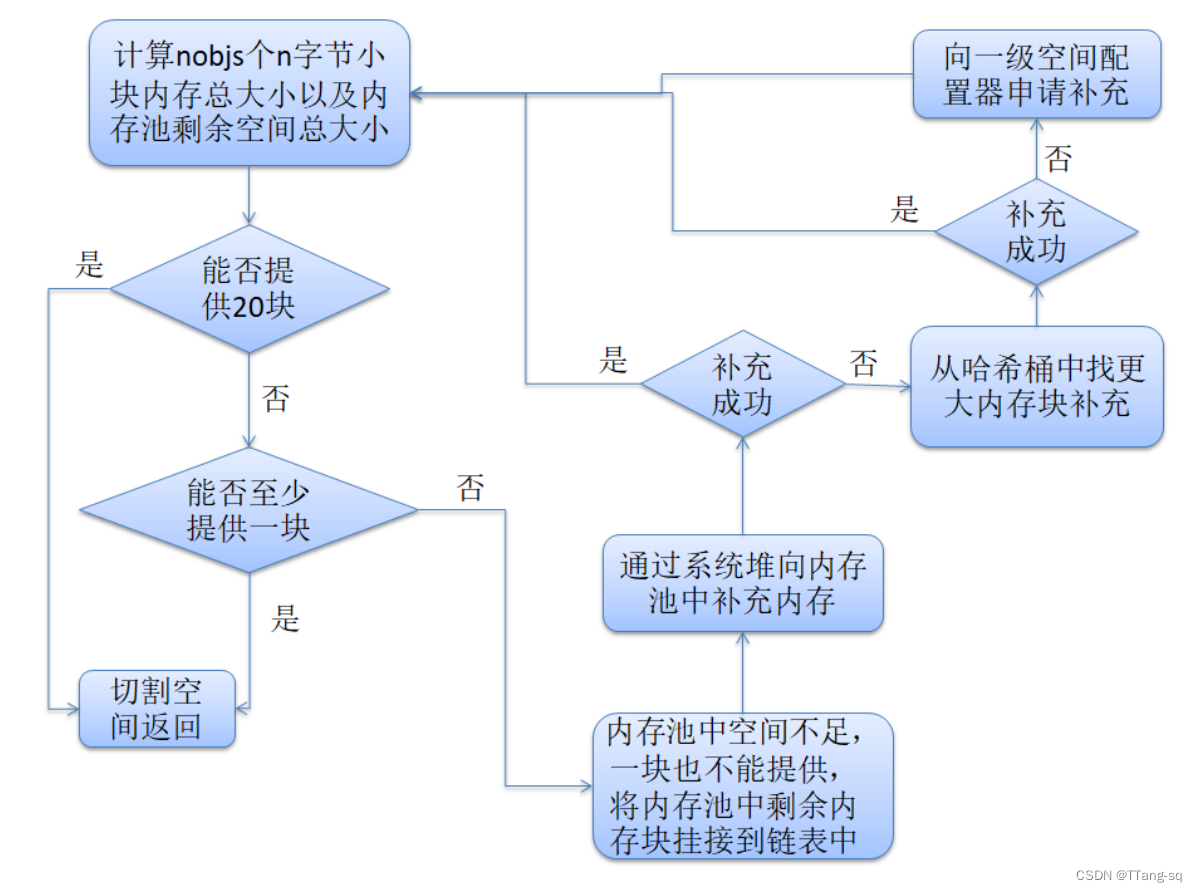

使用 refill() 填充内存块时,需注意:

桶下无可使用空间,向内存池接着索要

nobjs(20)个 n 字节小块,需要计算内存池剩余空间是否足够给出- 如果剩余空间足够,就给出空间

- 如果剩余空间不够 20 块,就把能分配整数块空间一块一块的先切割出去

- 不足一块时,将剩余内存挂接到链表中,通过系统堆向内存池中补充内存

- 如果补充成功正常使用

- 如果补充失败,从哈希桶中找到比请求空间更大的内存块进行补充

- 如果补充成功正常使用

- 如果再次补充失败,向一级空间配置器申请补充

- 若还是失败,则抛出异常

二级配置器空间回收时:

- 和申请一样,以 128 为分界线

- 大于 128 交给 一级空间配置器来释放

- 小与 128 则找到对应的哈希桶,头插 到其中

4.2.5 deque的内存分配策略

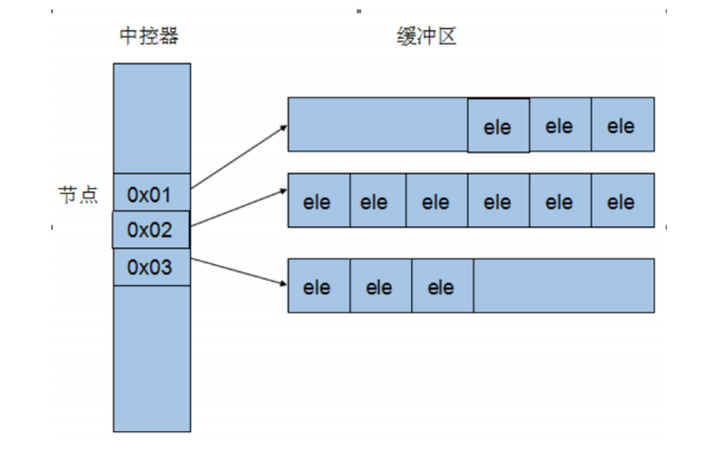

deque内部并不使用一个单一的连续内存块,而是将元素分割成多个固定大小的块(也称为缓冲区或页面),并通过一个中央映射数组(通常称为map)来管理这些块。具体来说,deque的内部结构可以分为以下几个部分:

中央映射数组(Map):

一个指针数组,指向各个数据块。

map本身也是动态分配的,可以根据需要增长或收缩。map允许deque在两端添加新的数据块,而无需移动现有的数据块。

数据块(Blocks):

每个数据块是一个固定大小的连续内存区域,用于存储元素。

数据块的大小通常与编译器和平台相关,但在大多数实现中,数据块的大小在运行时是固定的(如512字节或更多,具体取决于元素类型的大小)。

起始和结束指针:

deque 维护指向中央映射数组中第一个有效数据块的指针以及第一个无效数据块的指针。

这些指针帮助 deque 快速地在两端添加或删除数据块。

4.2.6 关联容器与无序关联容器的底层区别

关联容器如 map、set 底层通过红黑树实现(也可以通过AVL,但插入、删除时效率略低于红黑树),而无序关联容器底层通过哈希表实现。

| 数据结构 | 优点 | 缺点 |

|---|---|---|

| 红黑树/AVL(关联容器) | 1. 有序性,便于有序遍历和范围查找 2. 插入、删除和查找平均与最坏时间复杂度均为(O(log n)),性能稳定 3. 无需额外空间处理哈希冲突 |

1. 每个节点需存储指针和颜色等信息,空间开销大 2. 插入和删除后需旋转与颜色调整,操作复杂、效率低 3. 遍历效率低,需指针跳转,缓存命中率低(相比数组这些连续缓存结构而言),效率相对低 |

| 哈希表(无序关联容器) | 1. 理想情况下查找、插入和删除时间复杂度可达(O(1)),速度快 2. 只需存储键值对和少量冲突处理信息,空间利用率高 3. 适合处理大规模数据 |

1. 元素无序,不便于有序遍历和范围查找 2. 存在哈希冲突,处理不当性能会急剧下降,O(n) 3. 性能依赖哈希函数质量,函数不佳会增加冲突概率 |

4.2.7 map关联容器的设计模式?(什么是红黑树?)

红黑树相当于是一个二叉搜索树BST,它的插入、删除步骤包括BST的插入、删除,但涉及到了颜色的变化和旋转。红黑树并不是一个绝对平衡的二叉树,相比于AVL树,红黑树只是相对平衡的,它只要求满足红黑树的五大性质即可:

- 节点颜色:每个节点要么是红色,要么是黑色。

- 根节点颜色:根节点是黑色。

- 叶子节点颜色:所有叶子节点(NULL 节点,即空节点)都是黑色的。这里的叶子节点不存储实际数据,仅作为树的终端。

- 红色节点限制:如果一个节点是红色的,则它的两个子节点都是黑色的。也就是说,红色节点不能有红色的子节点(不能有2个连续的红色节点,但可以有2个连续的黑色节点)。

- 黑色平衡:从任意节点到其所有后代叶子节点的路径上,包含相同数量的黑色节点。这被称为每条路径上的黑色高度相同。

这五个性质保证了红黑树在插入和删除操作后,树的高度不会相差太大,从而维持了树的平衡。因此删除、查找效率和AVL树基本相同,均为**O(logn)**,但相比AVL树,红黑树在插入、删除后最多只需要旋转两次+颜色变换即可恢复红黑树的性质,而AVL需要严格平衡,复杂度明显高于红黑树。

而在查找方面,如果数据是随机乱序的,则BST树基本是平衡的,它的查找效率维持在O(logn),而一旦数据是有序的,那么BST就只会有左子树或右子树,此时的查找效率是O(n),而红黑树的查找效率基本维持在O(logn),因此红黑树的查找效率高于BST树。但因为红黑树不是严格的高度平衡,其树的高度可能会比 AVL 树略高,因此在查找操作上,红黑树的平均时间复杂度虽然也是 O(logn),但实际性能可能会略逊于 AVL 树。

开销方面,AVL节点内需要一个 int 保存高度,明显大于红黑树的 bool 颜色,开销是AVL大。

至于排序,我们可以通过中序遍历将通过AVL或红黑树实现的map的键值对有序存储至指定容器中。

4.2.8 中序遍历

1 | // 中序遍历辅助函数 |

key 会从小到大依次排列到 vector 中。

4.2.9 Vector底层实现和扩容⭐

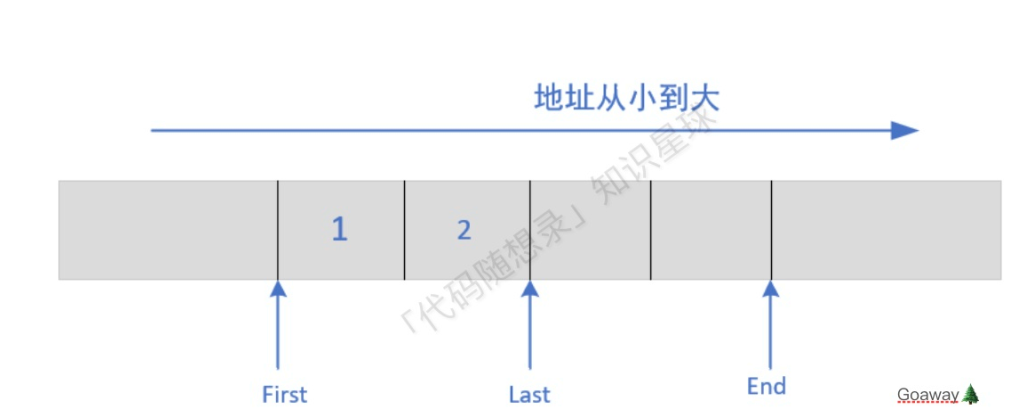

a)底层实现

Vector在堆中分配了一段连续的内存空间来存放元素 ,且分配了三个迭代器表示 vector 的容量。

(1) first : 指向的是vector中对象的起始字节位置

(2) last : 指向当前最后一个元素的末尾字节

(3) end : 指向整个vector容器所占用内存空间的末尾字

(1) last - first : 表示 vector 容器中目前已被使用的内存空间

(2) end - last : 表示 vector 容器目前空闲的内存空间

(3) end - first : 表示 vector 容器的容量

b)扩容

若集合已满(end - first < 元素类型占用的字节数),在新增数据的时候,就要分配⼀块更⼤的内存,将原来的数据复制过来,释放之前的内存,再插入新增的元素。所以对vector的任何操作,一旦引起空间重新配置,指向原vector的所有迭代器就都失效了

那么新增的容量选择多少合适?有什么方式可以选择?

1、固定扩容

机制:每次扩容的时候在原 capacity() 的基础上加上固定的容量,比如初始 capacity 为100,扩容⼀次为 capacity + 20,再扩容仍然为 capacity + 20;

缺点:考虑⼀种极端的情况, vector每次添加的元素数量刚好等于每次扩容固定增加的容量 + 1,就会造成⼀种情况,每添加⼀次元素就需要扩容⼀次,而扩容的时间花费十分⾼昂。所以固定扩容可能会面临多次扩容的情况,时间复杂度较高;

优点:固定扩容方式空间利用率比较高。

2、加倍扩容

机制:每次扩容的时候原 capacity 翻倍,比如初始 capcity = 100, 扩容一次变为 200, 再扩容变为 400;

优点:⼀次扩容 capacity 翻倍的方式使得正常情况下添加元素需要扩容的次数大大减少(预留空间较多),时间复杂度较低;

缺点:因为每次扩容空间翻倍,而很多空间没有利用上,空间利用率不如固定扩容。在实际应用中,一般采用空间换时间的策略,加倍扩容的使用次数多一些

4.2.10 迭代器删除元素(迭代器失效)⭐

对于序列容器 vector, deque来说,使⽤ erase(itertor) 后,后边的每个元素的迭代器都会失效,但是后边每个元素都会往前移动⼀个位置,并且 erase 会返回下⼀个有效的迭代器;此外, vector 底层进行扩容后,原有容器中的所有迭代器均会失效。vector insert新元素后,后面元素的迭代器也会失效。

对于关联容器 map set 来说,使⽤了 erase(iterator) 后,当前元素的迭代器失效,但是其结构是红⿊树,删除当前元素的,不会影响到下⼀个元素的迭代器,所以在调⽤ erase 之前,记录下⼀个元素的迭代器即可。

对于 list 来说,它使⽤了不连续分配的内存,并且它的 erase ⽅法也会返回下⼀个有效的 iterator,因此上⾯两种正确的⽅法都可以使⽤。

清空 vector 数据时,如果保存的数据项是指针类型,需要逐项 delete,否则会造成内存泄漏

4.2.11 迭代器的作用?和指针的对比

作用:

迭代器其实也是一种智能指针(模板类),重载了一些运算符(如 *、->、++、-- 等),使得迭代器在使用上类似于普通指针,但它可以完成更复杂的操作,主要是一种统一的接口来遍历和操作各种不同容器中的元素。

主要难点其实在于如何成为一个共用的工具?迭代器是如何判断其所指对象的类型是什么的,从而获取迭代器操作的算法的返回类型?

主要步骤是:函数模板的参数推导机制(但是无法函数返回类型只能是void或者非推导参数类型,因为我们不能提前知道推导的类型,自然返回类型也不能提前指定了,虽然可以通过auto加尾置返回类型解决,但我们的重心不在于这个)->类内嵌类型声明(虽然在类中可以为所指对象的类型定义别名,然后在模板函数中将该类传入,然后使用这个类定义的别名作为返回类型,但是如果传入给函数模板的是一个原始指针int*,那么就没办法了,int*可不是一个类,自然也没办法声明一个内嵌类型)->模板偏特化(通过一层类封装,使得传入模板函数的类或原始指针先进入一个封装类,在这个封装类中声明所指对象的类型的别名,然后将封装类中定义的类型别名作为模板参数返回类型即可)。

原理可参考:手撕 STL 迭代器源码与 traits 编程技法

和指针的对比:

迭代器不是指针,是类模板,表现的像指针。他只是模拟了指针的⼀些功能,通过重载了指针的⼀些操作符, ->、*、 ++、 –等。迭代器封装了指针,是⼀个“可遍历STL( Standard Template Library)容器内全部或部分元素”的对象, 本质是封装了原⽣指针,是指针概念的⼀种提升(lift),提供了⽐指针更⾼级的⾏为,相当于⼀种智能指针,他可以根据不同类型的数据结构来实现不同的++, –等操作。

迭代器返回的是对象引⽤⽽不是对象的值,所以cout只能输出迭代器使⽤*取值后的值⽽不能直接输出其⾃身。

4.2.12 vector和list的区别⭐

- 实现上

- vector 使用动态数组实现。连续的内存块,支持随机访问。在尾部进⾏插⼊/删除操作较快,但在中间或头部进行插入/删除会涉及大量元素的移动。

- list 使⽤双向链表实现。不连续的内存块,不支持随机访问。在任意位置进⾏插⼊/删除操作都是常数时间复杂度。

- 访问上

- vector⽀持通过索引进⾏快速随机访问。使⽤迭代器进⾏访问时,效率较⾼。

- List不⽀持通过索引进⾏快速随机访问。迭代器在访问时需要遍历链表,效率相对较低。

- 内存管理

- Vector使⽤动态数组,需要在预估元素数量时分配⼀块较⼤的内存空间,不够时才进⾏翻倍扩容

- list由于采⽤链表结构,动态分配的内存⽐较灵活。每个元素都有⾃⼰的内存块, list每次插⼊新节点都会进⾏内存申请

- 应用

- Vector适⽤于需要频繁随机访问、在尾部进⾏插⼊/删除操作的场景。

- list适⽤于需要频繁在中间或头部进⾏插⼊/删除操作、不要求随机访问的场景。

5. 其他

5.1 一个进程占用了系统中的哪些资源

- 内存资源:堆、栈、共享内存…

- CPU资源:时间片、上下文切换

- 文件和I/O资源:文件描述符、打开的文件

- 进程控制块(PCB)、信号量、互斥锁、管道、消息队列

- 网络资源:socket

5.2 linux/win 系统内存管理机制

虚拟内存、内存分页、内存分段

5.3 进程中断时发生了什么

中断触发

- 硬件中断:由外设(如键盘、硬盘、网卡)或 CPU 自身(如定时器)触发。

- 示例:用户按下键盘,键盘控制器发送中断信号到 CPU。

- 软件中断:通过系统调用(如

int 0x80)或异常(如除以零)触发。- 示例:进程调用

write()函数写入文件,触发软中断进入内核。

- 示例:进程调用

- 信号:由其他进程或内核发送的异步通知(如

SIGINT)。

中断响应

- 关中断:CPU 立即停止响应其他中断(防止嵌套中断导致混乱)。

- 保存当前上下文:

- 寄存器:保存通用寄存器(如 RAX、RBX)、段寄存器(CS、DS)等。

- 程序计数器(PC):记录中断发生时的指令位置。

- 栈指针(SP):保存当前栈的状态。

- 识别中断源:通过中断向量表(Interrupt Vector Table)找到对应的中断处理程序入口地址。

中断处理

- 执行中断服务程序(ISR):

- 硬件中断:处理外设请求(如读取键盘输入、DMA 完成)。

- 软件中断:执行系统调用(如分配内存、创建进程)。

- 信号处理:执行用户自定义的信号处理函数(如捕获

SIGINT时终止进程)。

- 可屏蔽性:

- 硬件中断可分为可屏蔽(如键盘)和不可屏蔽(如电源故障)。

- 软中断通常不可屏蔽,必须立即处理。

上下文恢复与进程调度

- 恢复上下文:从中断栈中弹出保存的寄存器值,恢复程序计数器。

- 开中断:允许 CPU 再次响应新的中断。

- 进程调度:

- 如果中断处理改变了进程状态(如唤醒等待 I/O 的进程),可能触发调度。

- 若原进程优先级未变,则继续执行;否则可能切换到更高优先级进程。

5.4 进程的控制方式有哪几种

进程控制的主要功能是对系统中的所有进程实施有效的管理,它具有创建新进程、撤销已有进程、实现进程状态转换等功能。

简化理解:反正进程控制就是要实现进程状态转换。

如何实现进程控制?

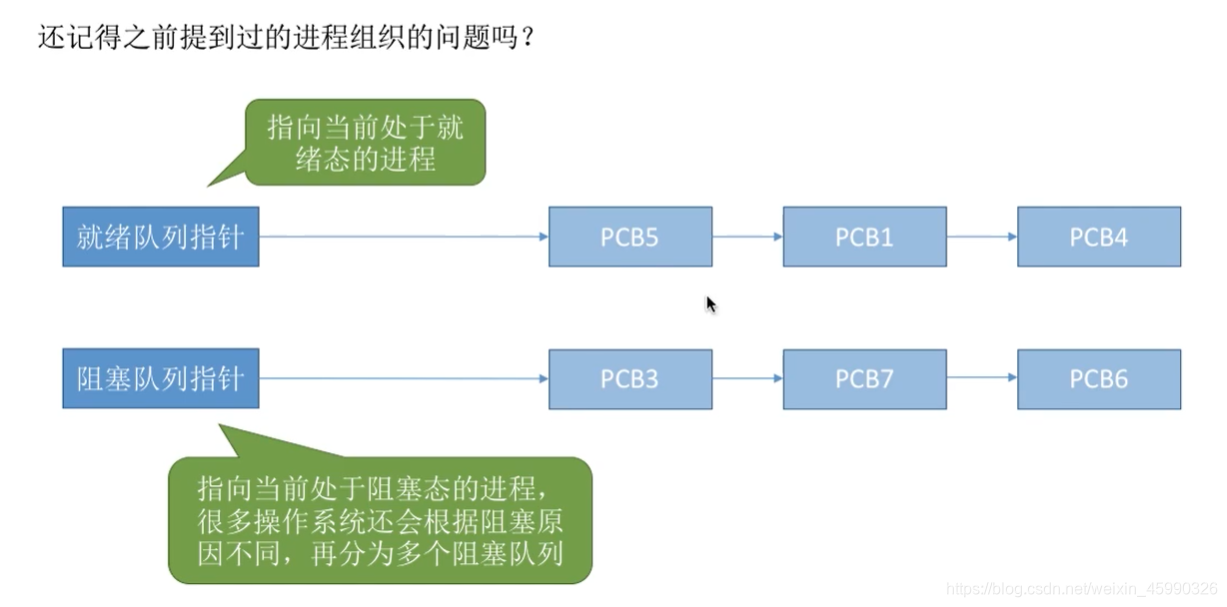

操作系统会把各个处于不同状态的进程对应的PCB挂到相应的一系列队列当中,用这种方式来管理组织进程的PCB

进程控制过程如下:

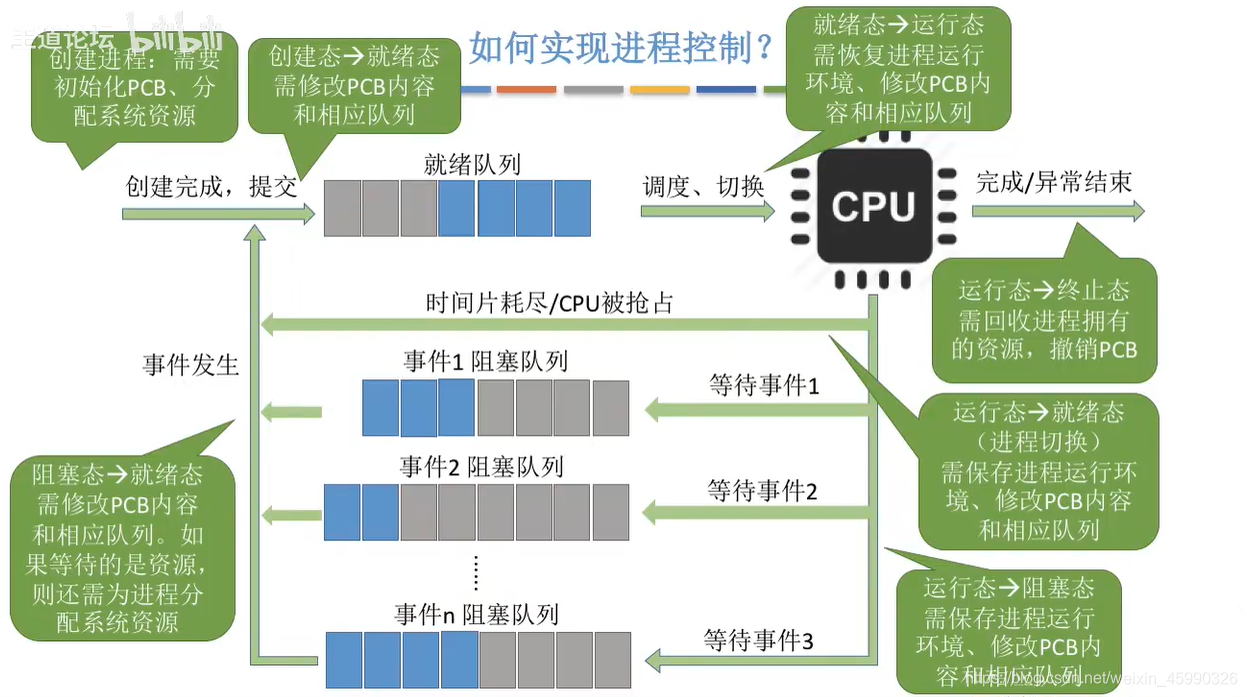

进程控制是通过原语实现的(创建原语、撤销原语、阻塞原语、唤醒原语、切换原语),原语就是通过原子操作实现的指令行,无论哪个原语,要做的无非三类事情:

- 更新PCB中的信息(如修改进程状态标志、将运行环境保存到PCB、从PCB恢复运行环境)

a.所有的进程控制原语一定都会修改进程状态标志(修改进程状态)

b.剥夺当前运行进程的CPU使用权必然需要保存其运行环境(保存上下文)

c.某进程开始运行前必然要恢复期运行环境(恢复现场) - 将PCB插入合适的队列

- 分配/回收资源

比如当一些引起进程创建的事件发生时,系统会调用创建原语进行以下操作:

- 申请空白的PCB

- 为新进程分配所需资源

- 初始化PCB

- 将PCB插入就绪队列

引起进程创建的事件一般有:

- 用户登录:分时系统中,用户登录成功,系统会为其建立一个新的进程

- 作业调度:多道批处理系统中,有新的作业放入内存时,会为其建立一个新的进程

- 提供服务:用户向操作系统提出某些请求时,会新建一个进程处理该请求

- 应用请求:由用户进程主动请求创建一个子进程

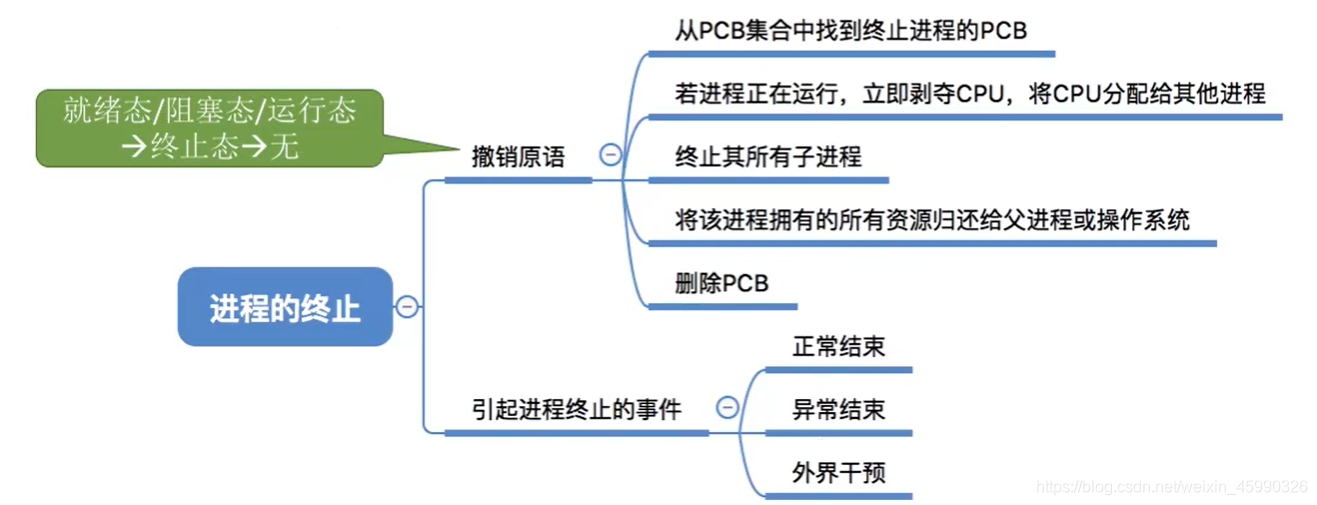

操作系统还提供了用于进程终止的撤销原语,无非也就是更新一些PCB的内容,回收一些资源,如果一个处于运行态的进程,它运行正常结束或者运行过程中由于异常结束(如:整数除零这种错误),这种情况会使操作系统使用撤销原语来使进程从运行态转变为终止态(不是阻塞态),最后完成终止态的一系列相关操作,这个进程就被彻底撤销了。

另外,如果一个进程处于就绪态或阻塞态,此时如果有外界干预(如:用户主动请求撤销这个进程,如:windows下任务管理器直接杀进程正在操作),那操作系统也会使用撤销原语,来使这个进程直接从就绪态或阻塞态直接转变为终止态,然后完成一系列工作之后,最后结束进程。

总而言之,无论是进程正常结束、运行时遇到了异常而结束还是外界用户主动干预,操作系统都会调用撤消原语,将该进程切换至终止态。

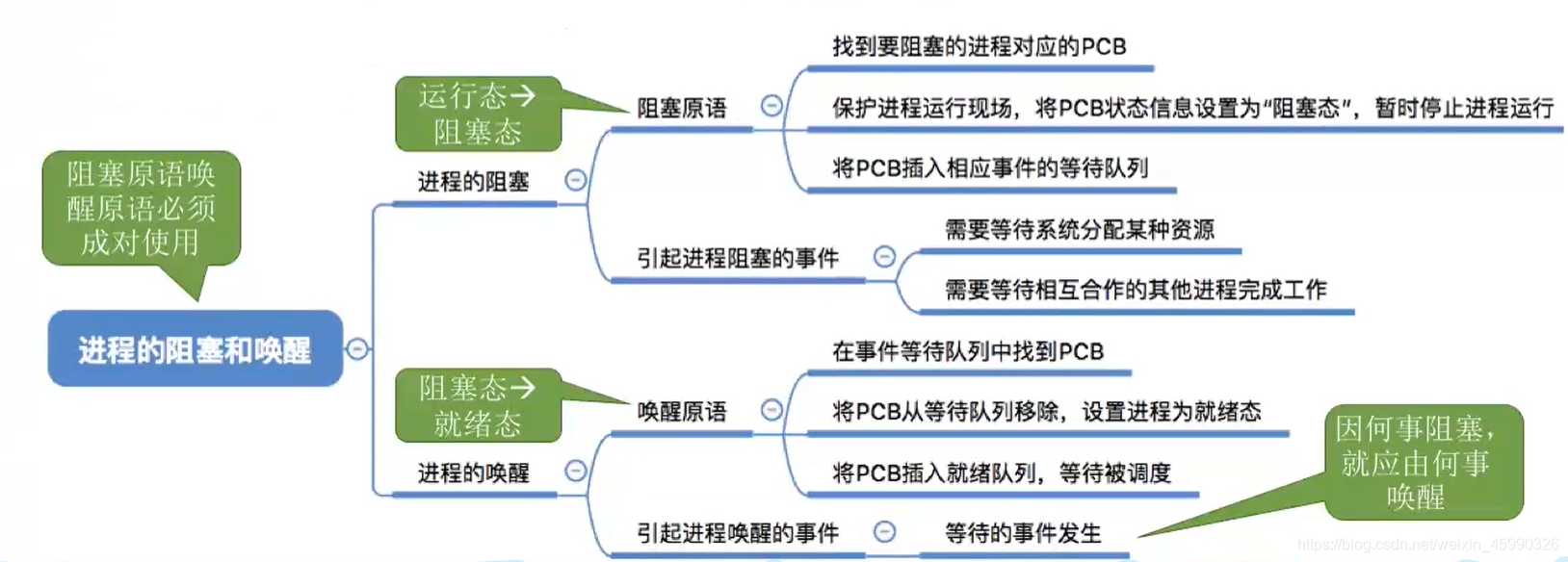

操作系统还提供了进程的阻塞和进程的唤醒相关的原语就是阻塞原语和唤醒原语。阻塞原语和唤醒原语所做的这一系列的工作,其实也是处理PCB的一些内容,或者把它插入到合适的队列,这样的一系列的工作,那么如果一个正在运行的进程,它需要等待系统分配某种资源,或者说需要等待某个事件的发生,操作系统就会使用阻塞原语把这个进程进行阻塞,由此这个进程会由运行态转变为阻塞态,那么当这个进程等待的事件发生之后,操作系统又会使用唤醒原语来把刚才阻塞的那个进程从阻塞态要转变为就绪态,那么需要注意的是,进程的唤醒,这个事件其实就是进程被阻塞的时候所等待的那个事件。因此,阻塞原语和唤醒原语应该是成对使用的,进程因为什么事件被阻塞,那么就应该因为什么事件被唤醒。

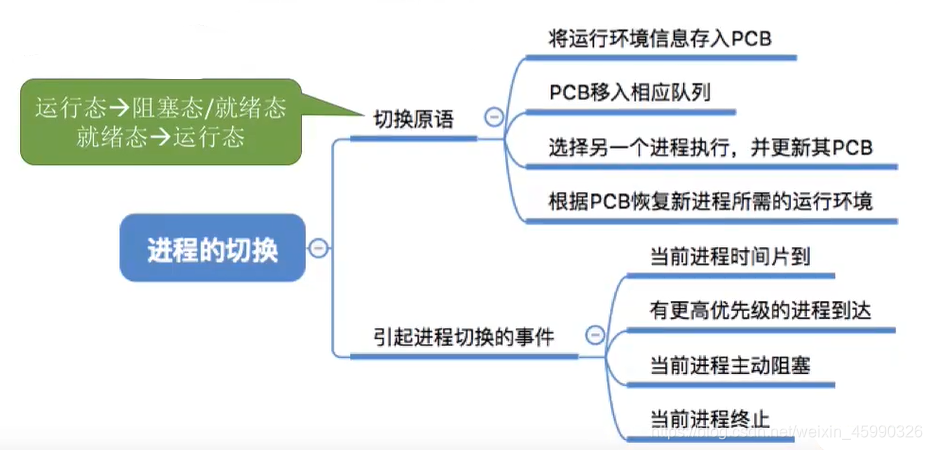

另外呢,操作系统还提供了进程切换相关的原语。进程切换相关的切换原语,其实实现的也是一些PCB相关的一系列的操作。那么像当前正在运行的进程时间片到或者有更高的进程到达,然后抢占了CPU,或者说当前正在执行的进程,主动的申请阻塞,或者说当前进程终止,这些都有可能导致进程的切换。这个切换原语,会让当前处于运行态的进程变为阻塞态或者就绪态,另外,又会让处于一个处于就绪态的进程进入到运行态,所以这是切换原语的作用。

5.5 PCB

进程控制块能对进程动态特征的集中反映。因为我们将程序运行起来,首先需要将代码和数据加载到内存中,然后cpu访问内存中的代码和数据。如果只有一个进程加载到内存中,cpu访问很简单,但如果由多个进程加载到内存中时,操作系统如何将这些加载到内存中的进程管理起来?

为了解决这个问题,操作系统会在内存中开辟一个结构体来存放相应的进程,即此时就需要引出关于程序控制块PCB。对于PCB结构体,我们即可为其命名为task/pcb struct,里面存放了进程相关的所有属性,方便系统分辨不同的进程的身份。

当程序被加载到内存运行时,操作系统会为其创建一个对应的 PCB 结构体,将进程的动态特征(如运行状态、资源占用)集中存储。多个进程的 PCB 结构体在内存中通过指针形成链表,就像一条锁链把所有进程串联起来。例如,每个 PCB 包含指向下一个 PCB 的指针,最终形成一个 “进程链表”。

操作系统通过遍历这条 “进程链表”,就能快速找到所有进程的 PCB 结构体,进而读取或修改进程属性。例如,当需要调度 CPU 执行某个进程时,操作系统只需遍历链表找到对应的 PCB,根据其中的内存地址和状态信息恢复进程运行。

PCB 的成员类型:

进程标识符:进程 pid,用于系统区分不同进程。ppid,记录父进程的pid(如果是父进程通过fork创建的子进程)

进程状态:运行、就绪、阻塞、僵尸等

优先级: 相对于其他进程的优先级。

程序计数器(PC): 程序中即将被执行的下一条指令的地址。

内存指针: 指向进程代码段、数据段、堆、栈的内存地址,帮助操作系统定位进程在内存中的位置。

上下文数据:保存 CPU 寄存器的当前值(如通用寄存器、状态寄存器),用于进程上下文切换时恢复现场。

其他信息:比如进程启动时间

5.6 多线程如何同步、异步操作

同步操作:互斥锁、内存栅栏、条件变量、原子操作

异步操作:线程池(线程池将任务提交与任务执行解耦,任务被立即加入任务队列,无需等待任务完成,主线程可继续执行其他操作)、async、future、promise、异步回调

5.7 中断和回调的区别

中断和回调是异步事件处理的两种核心机制。中断由硬件或内核强制触发,用于响应外设事件或系统调用,具有高优先级且运行于内核态,需保存完整上下文;回调则是软件设计模式,通过函数调用实现异步通知,运行于用户态且依赖事件注册机制。两者核心区别在于控制权来源(硬件 / 内核 vs 用户代码)和执行场景(底层硬件响应 vs 上层业务逻辑)。

| 对比项 | 中断 | 回调 |

|---|---|---|

| 触发来源 | 硬件信号或内核指令 | 用户代码或库函数主动调用 |

| 执行态 | 内核态(特权模式) | 用户态(非特权模式) |

| 异步性 | 完全异步(事件不可预测) | 同步或异步(取决于实现) |

| 优先级 | 硬件固定优先级(高于进程) | 取决于调用者执行优先级 |

| 资源开销 | 需保存 / 恢复完整上下文,开销大 | 仅函数调用开销,资源占用小 |

| 典型场景 | 外设数据接收、定时器超时 | 网络请求完成、GUI 事件响应 |

| 控制权 | 硬件 / 内核强制接管 | 用户代码主动控制调用时机 |

回调的同步异步区别:

- 同步回调是回调在事件发生后立即执行,与主程序同步完成,与主程序共享同一调用栈,执行期间阻塞当前线程。

- 异步回调在事件发生后不立即执行,而是回调加入任务队列,等待合适时机执行,可能在不同线程或事件循环中执行,不阻塞主程序。

5.8 fork()

fork() 系统调用的主要功能是创建一个新的进程,这个新进程被称为子进程,而调用 fork() 的进程则被称为父进程。子进程是父进程的一个副本,它几乎复制了父进程的所有内容,包括代码段、数据段、堆、栈等。

- 在父进程中,

fork()返回子进程的进程 ID(PID),这是一个正整数。 - 在子进程中,

fork()返回 0。 - 如果

fork()调用失败,它会返回 -1,并设置相应的错误码。

当 fork() 被调用时,操作系统会为子进程分配新的进程控制块(PCB),并将父进程的大部分内容复制到子进程中。这包括代码段、数据段(全局变量、静态变量等)、堆、栈(子进程有自己独立的堆和栈空间,但初始时内容与父进程相同)等,但子进程有自己独立的内存空间,对一个进程的内存修改不会影响另一个进程。

fork() 调用之后,父进程和子进程会从 fork() 调用的下一条语句开始独立执行。它们的执行顺序是不确定的,取决于操作系统的调度算法。

如果父进程在子进程结束之前退出,子进程会成为孤儿进程,被

init进程收养。如果子进程结束后,父进程没有及时回收子进程的资源,子进程会成为僵尸进程,占用系统资源。

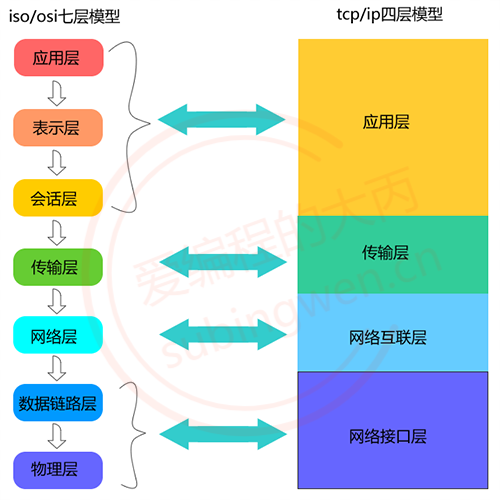

5.9 OSI/TCP模型

- 物理层:负责最后将信息编码成电流脉冲或其它信号用于网上传输

- 数据链路层:

- 数据链路层通过物理网络链路供数据传输。

- 规定了0和1的分包形式,确定了网络数据包的形式;

- 网络层

- 网络层负责在源和终点之间建立连接;

- 此处需要确定计算机的位置,通过IPv4,IPv6格式的IP地址来找到对应的主机

- 传输层

- 传输层向高层提供可靠的端到端的网络数据流服务。

- 每一个应用程序都会在网卡注册一个端口号,该层就是端口与端口的通信

- 会话层

- 会话层建立、管理和终止表示层与实体之间的通信会话;

- 建立一个连接(自动的手机信息、自动的网络寻址);

- 表示层:

- 对应用层数据编码和转化, 确保以一个系统应用层发送的信息 可以被另一个系统应用层识别;

5.10 CAS和ABA

CAS是解决多线程并行情况下使用锁造成性能损耗的一种机制。

- CAS操作包含三个操作数——内存位置(V)、预期原值(A)、新值(B)。

- 如果内存位置的值与预期原值相匹配,那么处理器会自动将该位置值更新为新值。

- 否则,处理器不做任何操作。

- 无论哪种情况,它都会在CAS指令之前返回该位置的值。

- CAS有效地说明了“我认为位置V应该包含值A;如果包含该值,则将B放到这个位置;否则,不要更改该位置,只告诉我这个位置现在的值即可。

一个 CAS 涉及到以下操作:

假设内存中的原数据V,旧的预期值A,需要修改的新值B

- 比较 A 与 V 是否相等

- 如果比较相等,将 B 写入 V

- 返回操作是否成功

C++11中的CAS,C++11中的STL中的atomic类的函数可以让你跨平台。

1 | template< class T > bool atomic_compare_exchange_weak( std::atomic* obj,T* expected, T desired ); |

compare_exchange_weak:尝试将原子对象的当前值与预期值进行比较,如果相等则将其更新为新值(不是将expected的值赋给flag,而是有另外一个设定值)并返回true;否则,将原子对象的值加载进expected(进行加载操作)并返回false。此操作可能会由于某些硬件的特性而出现假失败,需要在循环中重试。1

2

3

4std::atomic<bool> flag{ false }; // 初始化为 false

bool expected = false; // 比较值

while (!flag.compare_exchange_weak(expected, true));它比较原子对象的当前持有值(相当于先调用

head.load())与预期值expected是否相等。如果相等,则将原子对象的值更新为新值(此例为

true),并返回true。如果不相等,则不会更新原子对象的值,并将原子对象的当前值加载到

expected中,返回false。

返回

false即代表出现了假失败,因此需要在循环中重试。。compare_exchange_strong:类似于compare_exchange_weak,但不会出现假失败,因此不需要重试。适用于需要确保操作成功的场合。1

2

3

4

5

6

7

8

9

10

11

12std::atomic<bool> flag{ false }; // 初始化为 false

bool expected = false; // 比较值

void try_set_flag() {

// 判断 flag 的值与 expected 是否相同,如果相同,将 flag 修改为我们设定的值,并返回 true

if (flag.compare_exchange_strong(expected, true)) {

std::cout << "flag 为 false,设为 true。\n";

}

else { // 如果不相同,将 expected 的值修改为我们设定的值,并返回false

std::cout << "flag 为 true, expected 设为 true。\n";

}

}假设有两个线程运行

try_set_flag函数,那么第一个线程调用compare_exchange_strong将原子对象flag设置为true。第二个线程调用compare_exchange_strong,当前原子对象的值为true,而expected为false,不相等,将原子对象的值设置给expected。此时flag与expected均为true。1

2

3

4

5

6std::thread t1{ try_set_flag };

std::thread t2{ try_set_flag };

t1.join();

t2.join();

std::cout << "flag: " << std::boolalpha << flag << '\n';

std::cout << "expected: " << std::boolalpha << expected << '\n';输出为:

1

2

3

4flag 为 false,flag 设为 true。

flag 为 true, expected 设为 true。

flag: true

expected: true

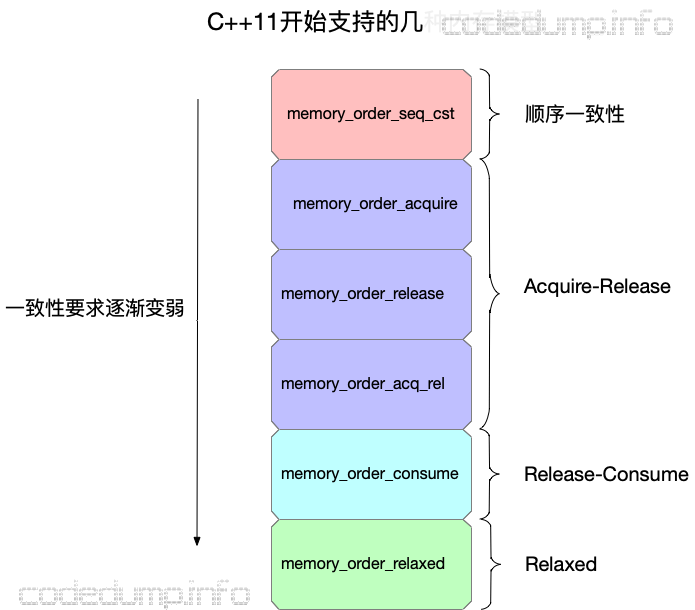

与 exchange 的另一个不同是,compare_exchange_weak 和 compare_exchange_strong 允许指定成功和失败情况下的内存次序。这意味着可以根据成功或失败的情况,为原子操作指定不同的内存次序。

1 | std::atomic<bool> data{ false }; |

- exchange 也是读改写操作,只不过它没有比较,而是直接修改原子变量,并返回原子变量持有的旧值

1 | x = b.exchange(false, std::memory_order_acq_rel); // 将 b 修改为false,并返回 b 持有的旧值 |

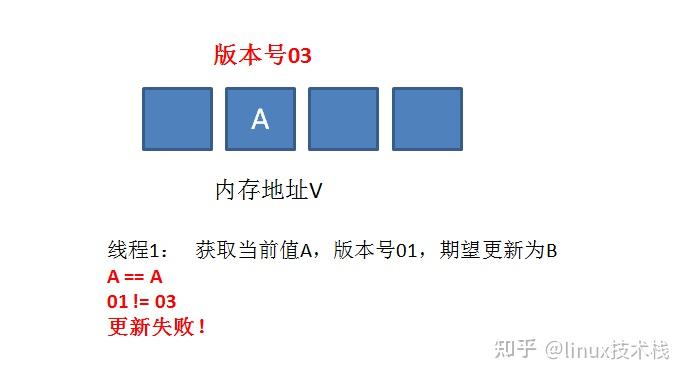

ABA问题描述:

- 进程P1在共享变量中读到值为A

- P1被抢占了,进程P2执行

- P2把共享变量里的值从A改成了B,再改回到A,此时被P1抢占。

- P1回来看到共享变量里的值没有被改变,于是继续执行。

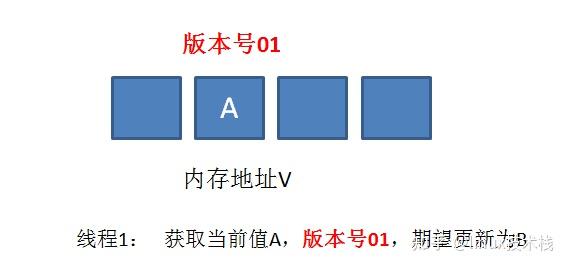

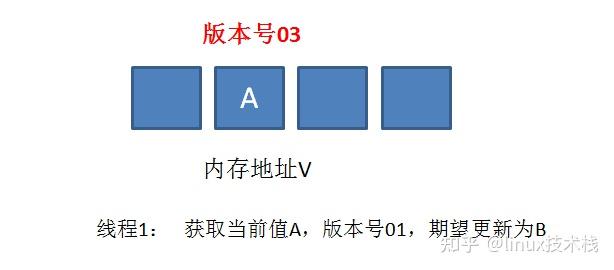

真正要做到严谨的CAS机制,我们在compare阶段不仅要比较期望值A和地址V中的实际值,还要比较变量的版本号是否一致。

举个栗子:

假设地址V中存储着变量值A,当前版本号是01。线程1获取了当前值A和版本号01,想要更新为B,但是被阻塞了。

这时候,内存地址V中变量发生了多次改变,版本号提升为03,但是变量值仍然是A

随后线程1恢复运行,进行compare操作。经过比较,线程1所获得的值和地址的实际值都是A,但是版本号不相等,所以这一次更新失败

解决思路:增加版本号,每次变量更新时把版本号+1,A-B-A就变成了1A-2B-3A。JDK5之后的atomic包提供了AtomicStampedReference来解决ABA问题,它的compareAndSet方法会首先检查当前引用是否等于预期引用,并且当前标志是否等于预期标志。全部相等,才会以原子方式将该引用、该标志的值设置为更新值。

5.11 最烦恼的解析

1 | class MyClass { |

在上面的代码中,MyClass obj(); 被编译器解析为一个返回 MyClass 类型的函数 obj,而不是一个 MyClass 类型的对象。这种情况被称为“最烦恼的解析”,导致编译器将原本应该是对象的构造解析为函数的声明。原因:

- 语法规则:C++ 的语法规则允许使用类名后跟括号的形式来声明函数(仿函数)。如果没有其他上下文,编译器会选择这种解析方式。

- 上下文歧义:在某些情况下,编译器无法明确判断你是想要创建一个对象还是声明一个函数,因此选择最符合语法的解析方式。

为了避免最烦恼的解析,可以使用如下方法:

1 | // 1. 使用花括号 |

所以我们如果使用仿函数作为可调用对象传入时,可以这样做:

1 | class background_task { |

但如果仿函数中有参数,那么就不会造成”最烦恼的解析”,因为上下文有解释,我是要调用仿函数(因为传入的参数和仿函数对应,构造函数与其不对应),比如:

1 | class background_task { |

“最烦恼的解析”一般在无传入参数的情况下发生。

5.12 为什么要使用join()等待子线程完成

虽然使用

std::thread创建的线程在结束时会自动释放其资源,但在主线程(或创建线程的线程)中仍需要等待其子线程结束。我们需要在主线程中显式调用join()函数等待子线程的结束,子线程结束后主线程才会继续运行。

原因如下:

- 如果创建的子线程在其执行过程中没有被主线程等待,那么当主线程结束或被销毁时,操作系统将会提前终止这个子线程,这可能导致子线程的资源(如内存、文件句柄等)不会被释放,产生资源泄漏。

- 如果不调用

join(),主线程在没有等待子线程结束的情况下继续执行,可能会导致程序在子线程完成之前就结束,从而未能正确处理子线程的结果(子线程的结果可能不会被主线程处理)。 - 如果主线程需要依赖于子线程完成某些任务(例如数据处理或文件写入),需要通过

join()确保子线程在主线程继续执行之前完成,可以避免因数据未更新而导致的不一致性。

线程的回收通过线程的析构函数来完成,即执行

terminate操作。

5.13 detach() 不要将局部变量按引用传入

可以使用detach允许子线程采用分离的方式在后台独自运行,不受主线程影响。主线程和子线程执行各自的任务,使用各自的资源。

注意:当一个线程被分离后,主线程将无法直接管理它,也无法使用

join()等待被分离的线程结束。处理日志记录或监控任务这些线程一般会让其在后台持续运行,使用detach。

1 | struct func { |

detach使用时有一些风险,比如上述代码。

当主线程调用oops时,会创建一个线程执行myfunc的重载()运算符,然后将主线程将oops创建的一个线程分离。但注意,当oops执行到 '}' 时,局部变量 some_local_state 会被释放,但引用(这里是引用传递而不是按值传递,按值传递不会引起该错误,因为线程中已经有一个自己的拷贝副本了)该局部资源的子线程 functhread 却仍然在后台运行,容易发生错误。

我们可以采取一些措施解决该问题:

- 通过智能指针传递局部变量,因为引用计数会随着赋值增加,可保证局部变量在使用期间不被释放,避免悬空指针的问题(网络编程中学习的伪闭包原理)。

- 按值传递,将局部变量的值作为参数传递而不是按引用传递,这么做需要局部变量有拷贝复制的功能,而且拷贝耗费空间和效率。

- 使用

join()确保局部变量的生命周期,保证局部变量被释放前线程已经运行结束,但是可能会影响运行逻辑。

5.14 线程守卫&&joinable()

当启动一个子线程时,子线程和主线程是并发运行的。如果主线程由于某种原因崩溃(例如未捕获的异常),则整个进程将会终止(主线程崩溃或者结束时,主进程会回收所有线程的资源),这意味着所有正在运行的线程,包括子线程(不管有没有被detach)都会被强制结束,导致子线程未完成的操作(如数据库写入)被中断。这可能会导致子线程待写入的信息丢失。

为了防止主线程崩溃导致子线程异常退出,可以在主线程中捕获可能抛出的异常,在捕获到异常后,可以选择在主线程中等待所有子线程完成。这样可以确保即使主线程遇到问题,子线程仍然能够完成其操作,并安全地结束。

但是这样太过于繁琐,我们还得捕获异常后将对应的线程进行join,但如果我们有多个线程和多个异常呢?难道还要一个个的组合,写异常处理?

可以使用RAII技术:

1 | class thread_guard { |

joinable()是std::thread的一个成员函数,返回一个布尔值,指示线程是否可连接(即是否已创建且尚未调用join()或detach()),如果_t是一个有效的线程对象且没有调用join()或detach(),那么调用join等待该线程结束。

我们可以将需要保护的线程(可能发生异常错误的线程)传递给thread_guard创建一个实例,如果主线程异常发生,保护子线程实例的析构函数会自动调用,确保主线程发生异常时,子线程也能被正确管理,防止资源泄漏

举例:

1 | void auto_guard() { |

如上例所示,通过thread_guard 构造一个新实例来保护线程t,那么即使在 auto_guard 函数中发生异常,thread_guard 也会确保线程t被正确管理,避免资源泄漏。

5.15 线程中使用引用

在创建线程时,使用

std::thread来传递参数时,参数是以拷贝的方式传递的。即使你传入的是一个左值(如一个变量),std::thread会在内部创建该参数的拷贝。但是在main函数中,如果传入的实参是左值,形参类型是引用,那么函数不会创建副本,而是直接对传入的值进行修改。

主线程:当在主线程中调用函数时(没有创建线程,而是直接调用),参数是按值传递还是按引用传递取决于函数的参数声明。如果函数的参数是引用类型(如 int&),那么传递的是对原始变量的引用,可以直接修改这个变量。

1 | void change_param(int& param) { |

子线程:当在子线程中调用函数时,即使参数在函数定义中是引用类型(如 int&),如果在 std::thread 创建线程时直接传递一个变量(如 some_param),这个变量仍会被复制到线程中,子线程内部的修改不会影响主线程中的原始变量。

1 | void change_param(int& param) { |

而且,上面这段代码和下面这段代码相同,都会报错:

1 | void change_param(int& param) { |

即使函数 change_param 的参数为int&类型,我们传递给t2的构造函数为some_param,也不会达到在change_param函数内部修改关联到外部some_param的效果。

因为some_param是外部传给函数ref_oops实参的拷贝(左值,这里的拷贝不是右值,它仍然可以取地址,右值一般只会在字面常量、表达式返回值、函数非左值引用返回值中出现),左值传递给线程thread的构造函数之后会被保存为右值引用(thread内部通过move,传入左值会被保存为右值,如果传入右值类型不会变化),右值如果传给调用对象change_param就会报错。因为change_param中的参数是左值引用,左值引用不能接收右值。有两种方法可以修正:

方法一:修改 change_param 的参数为 const 引用类型

1 | void change_param(const int& param) { |

但缺点是,不能对some_param进行修改了,因为**const int& 既可以用于传递左值引用,也可以用于传递右值**,唯独不能修改传递过来的值。

方法二:传递 std::ref

1 | void change_param(int& param) { |

第一种方法是直接修改可调用对象参数列表的类型,使其可以接受右值类型。

第二种方法其实还是将左值参数通过ref进行包装,使得thread内部不会将其引用类型delay,这样传递给调用对象的参数就仍是左值引用,而不是右值引用。

那么如果我传递的是一个左值,而不是实参的拷贝呢,会不会还有问题?

1 | void change_param(int& param) { |

该段函数中,我们传给线程调用对象change_param的参数是一个左值,而change_param形参的类型是引用,那么这样按理说应该是正确的,即线程内部对some_param的处理会影响到外部的some_param。但是,要注意线程无视引用,即使你传入的是左值,形参是引用,参数同样会被拷贝,除非你按引用传入(ref),或者传入的实参本来就是个引用。

1 | void ref_oops() { |

线程调用中,左值同样要加ref显式变为引用。

5.16 yield()

在线程中调用 yield() 函数之后,处于运行态的线程会主动让出自己已经抢到的CPU时间片,最终变为就绪态(就绪态的线程需要再次争抢CPU时间片,抢到之后才会变成运行态,这时候程序才会继续向下运行),这样其它的线程就有更大的概率能够抢到CPU时间片了。

使用这个函数的时候需要注意一点,线程调用了yield()之后会主动放弃CPU资源,但是这个变为就绪态的线程会马上参与到下一轮CPU的抢夺战中,不排除它能继续抢到CPU时间片的情况,这是概率问题。

5.17 thread如何避免传入的对象是thread

虽然thread的拷贝构造函数被delete,但如果将thead作为可调用对象传入thread的构造函数时,仍会执行,但thread自定义的构造函数中有以下操作,可避免thead的拷贝操作:

1 | template <class _Fn, class... _Args, enable_if_t<!is_same_v<_Remove_cvref_t<_Fn>, thread>, int> = 0> |

enable_if_t:这是一个 *SFINAE(Substitution Failure Is Not An Error)技术,用于在模板实例化过程中进行条件编译*。这里的条件 !is_same_v<_Remove_cvref_t<_Fn>, thread> 确保 _Fn 的类型在去除 const/volatile 修饰和引用后,不是 std::thread 类型本身,从而避免将 std::thread 对象作为函数参数,进一步避免线程的拷贝。**

关于这个约束你可能有问题,因为

std::thread他并没有operator()的重载,不是可调用类型,也就是说不能将std::thread作为可调用参数传入,那么这个enable_if_t的意义是什么呢?

1 | struct X{ |

在上段代码中,创建了一个 X 对象 x1,通过模板构造函数,传入了一个 Lambda 表达式(无参数的空函数)。模板构造函数匹配成功,因此 x1 被成功构造。

当试图通过已有的 X 对象 x1 创建另一个 X 对象 x2 时,编译器会选择模板构造函数。这是因为 x1 是一个 X 类型的对象,而模板构造函数可以接受任意类型(包括 X),并且与参数类型的匹配规则使得它可以接受一个 X 对象。这个过程不会导致编译错误,因为模板构造函数并不依赖于传入的对象是否是可调用的(构造函数的选择是基于类型匹配和参数的匹配,而不是基于可调用性),尽管 x1 不是可调用类型,编译器选择了这个构造函数来匹配。

以上这段代码可以正常的通过编译。这是重载决议的事情,但我们知道,std::thread是不可复制的,这种代码自然不应该让它通过编译,选择到我们的有参构造,所以我们添加一个约束让其不能选择到我们的有参构造:

1 | template <class Fn, class... Args, std::enable_if_t<!std::is_same_v<std::remove_cvref_t<Fn>, X>, int> = 0> |

这样,这段代码就会正常的出现编译错误,信息如下:

1 | error C2280: “X::X(const X &)”: 尝试引用已删除的函数 |

5.18 joining_thread

线程守卫(RAII技术),即主线程出现异常时,希望子线程能够运行结束后才退出主程序。其实 joining_thread 就是一个自带RAII技术的 thread类,它和 std::thread 的区别就是析构函数会自动 join

joining_thread 是 C++17标准的备选提案,但是并没有被引进,直至它改名为 std::jthread 后,进入了C++20标准的议程(现已被正式纳入C++20标准)

并且 joining_thread 的赋值运算符在将将一个线程的管理权交给一个已经绑定线程的变量时,不会立即调用 terminate 引发崩溃,而是先 jion() 然后转移另一个线程的管理权。

1 | joining_thread& operator=(std::thread&& other)noexcept { |

5.19 std::jthread

std::jthread 相比于 C++11 引入的 std::thread,只是多了两个功能:

- RAII 管理:在析构时自动调用 join()。

- 线程停止功能:线程的取消/停止。

std::jthread 所谓的线程停止只是一种基于用户代码的控制机制,而不是一种与操作系统系统有关系的线程终止。使用 std::stop_source 和std::stop_token 提供了一种优雅地请求线程停止的方式,但实际上停止的决定和实现都由用户代码来完成。如下:

1 | using namespace std::literals::chrono_literals; |

该段代码主要用于创建一个可以响应停止请求的线程。

- 当

std::jthread对象超出作用域时,它会自动调用request_stop()请求停止线程,并在销毁时调用join()等待线程结束。 std::stop_token允许线程检查是否接收到停止请求。在函数 f 中,循环体检查stop_token.stop_requested(),如果返回 false,则继续执行;否则退出循环。- 在每次循环中,打印当前值并将其递增,然后线程休眠 200 毫秒。这样,每个数字的打印之间有一定的间隔。

- 在 main 函数中,主线程休眠 3 秒。这段时间内,f 函数将打印数字(大约会打印 15 个数字,因为 3 秒内会输出 1 到 15)。主线程结束后,

jthread会自动请求停止并等待 f 函数完成。

std::jthread 提供了三个成员函数进行所谓的线程停止:

get_stop_source:返回与jthread对象关联的std::stop_source,允许从外部请求线程停止。get_stop_token:返回与jthread对象停止状态关联的std::stop_token,允许检查是否有停止请求。request_stop:请求线程停止。

上面那段代码中,这三个函数并没有被显式调用,不过在 jthread 的析构函数中,会调用 request_stop 请求线程停止:

1 | void _Try_cancel_and_join() noexcept { |

至于 std::jthread thread{ f, 1 } 函数 f 的 std::stop_token 的形参是谁传递的?其实就是线程对象自己调用get_token()传递的 ,源码一眼便可发现:

1 | template <class _Fn, class... _Args, enable_if_t<!is_same_v<remove_cvref_t<_Fn>, jthread>, int> = 0> |

std::stop_source:

- 这是一个可以发出停止请求的类型。当你调用

stop_source的request_stop()方法时,它会设置内部的停止状态为“已请求停止”。 - 任何持有与这个

stop_source关联的std::stop_token对象都能检查到这个停止请求。

std::stop_token:

- 这是一个可以检查停止请求的类型。线程内部可以定期检查

stop_token是否收到了停止请求。 - 通过调用

stop_token.stop_requested(),线程可以检测到停止状态是否已被设置为“已请求停止”。

5.20 什么是数据竞争

当某个表达式的求值写入某个内存位置,而另一求值读或修改同一内存位置时,称这些表达式冲突。拥有两个冲突的求值的程序就有数据竞争,除非

- 两个求值都在同一线程上,或者在同一信号处理函数中执行,或

- 两个冲突的求值都是原子操作(见 std::atomic),或

- 一个冲突的求值发生早于 另一个(见 std::memory_order)

5.21 lock_guard

我们可以使用lock_guard进行自动加解锁,也就是之前说的RAII技术,当lock_guard被实例化的时候进行加锁,当lock_guard被析构的时候进行解锁。

1 | void use_lock() { |

lock_guard 在作用域结束时自动调用其析构函数解锁,这么做的一个好处是简化了一些特殊情况从函数中返回的写法,比如异常或者条件不满足时,函数内部直接return,锁也会自动解开。

lock_guard 也是一个“管理类”模板,用来管理互斥量的上锁与解锁,可以看一下 lock_guard 的源码实现:

1 | _EXPORT_STD template <class _Mutex> |

首先lock_guard 作为管理类,要求不可复制,我们定义复制构造与复制赋值为弃置函数。

它只保有一个私有数据成员,一个引用,用来引用互斥量。构造函数中初始化这个引用,同时上锁,析构函数中解锁,这是一个非常典型的 RAII 式的管理。

同时它还提供一个有额外std::adopt_lock_t参数的构造函数 ,如果使用这个构造函数,则构造函数不会上锁。 adopt_lock 表示这个互斥量的锁已经在其他地方被获取,这样,lock_guard 会在构造时不再调用 lock() 方法,而是直接采用已锁定的状态。这个功能在某些情况下非常有用,尤其是在希望将一个已经被锁定的互斥量传递给 lock_guard 的时候。比如:

1 | std::mutex mtx; |

我们一般使用 lock_guard 时,经常使用下面的形式:

1 | std::mutex mtx; |

使用{}创建了一个块作用域,限制了对象 lc 的生存期,进入作用域构造 lock_guard 的时候上锁(lock),离开作用域析构的时候解锁。

我们要尽可能的让互斥量上锁的粒度小,只用来确保必须的共享资源的线程安全。“粒度”通常用于描述锁定的范围大小,较小的粒度意味着锁定的范围更小,因此有更好的性能和更少的竞争。

5.22 try_lock

try_lock 是互斥量中的一种尝试上锁的方式。与常规的 lock 不同,try_lock 会尝试上锁,但如果锁已经被其他线程占用,则不会阻塞当前线程,而是立即返回。

它的返回类型是 bool ,如果上锁成功就返回 true,失败就返回 false。

这种方法在多线程编程中很有用,特别是在需要保护临界区的同时,又不想线程因为等待锁而阻塞的情况下。

1 | std::mutex mtx; |

5.23 unique_lock

unique_lock 也是一种管理类模板(满足可移动构造和可移动赋值但不满足可复制构造或可复制赋值),灵活性比lock_guard高很多(允许手动加解锁、延迟锁定、有时限的锁定尝试、递归锁定、所有权转移和与条件变量一同使用,存在RAII回收),但是效率比较差,内存占用也比较多。

工作中一般使用lock_guard ,但在和条件变量配合使用或者希望更加自由时可以时候unique_lock。

5.24 once_flage 和 call_once

once_flage 和 call_once也相当于一种锁,std::call_once 确保所给的函数在多线程环境中只会被调用一次(仅仅只会调用一次),即使多个线程同时调用 call_once,只有一个线程会实际执行该函数,其它线程会等待。

1 | std::once_flag s_flag; |

其实这也是C++11及之后为什么局部静态变量是线程安全的了。

- 在C++11之前,多线程同时首次调用

GetInstance()时,可能触发竞态初始化,导致未定义行为(如重复初始化、值覆盖)。 - 在C++11及之后,多个线程首次初始化时,仅有一个线程执行初始化,其他线程等待直至完成。

- 通过原子标志 + 互斥锁实现,仅首个线程执行初始化,后续线程通过原子操作感知已初始化,避免加锁,确保 “初始化完成” 的状态全局可见

原理就是多线程中执行了once_flage 和 call_once,保证多线程初始化时仅有一个线程执行初始化。

5.25 不得向锁所在的作用域之外传递指针和引用

不得向锁所在的作用域之外传递指针和引用,指向受保护的共享数据没无论是通过函数返回值将它们保存到对外可见 内存,还是将它们作为参数传递给使用者提供的函数。简而言之:切勿将受保护数据的指针或引用传递到互斥量作用域之外,不然保护将形同虚设。

5.26 死锁

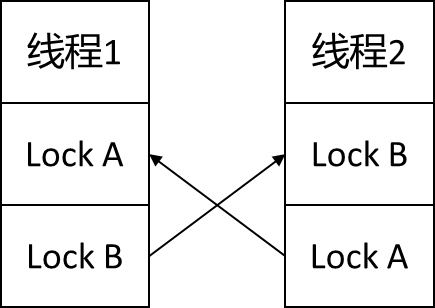

死锁其实就是不同线程在互斥上争抢锁:有两个线程,都需要同时锁住两个互斥,才可以进行某项操作,但它们分别都只锁住了一个互斥,都等着再给另一个互斥加锁。于时,双方毫无进展,因为它们都在等待对方解锁互斥。这种情形为死锁。

第一种情况:防范死锁的建议通常是:始终按相同的顺序对两个互斥加锁。这也是层级加锁的实现原理。比如我们这里将线程1和线程2都按 A->B 的顺序进行加锁,一般情况下就不会发生死锁。

第二种情况:但是有的时候即使固定锁顺序,依旧会产生问题。当有多个互斥量保护同一个类的对象时,对于相同类型的两个不同对象进行数据的交换操作,为了保证数据交换的正确性,就要避免其它线程修改,确保每个对象的互斥量都锁住自己要保护的区域。如果按照前面的的选择一个固定的顺序上锁解锁,则毫无意义,比如:

1 | struct X{ |

我们对同一个类的两个实例进行数据交换时,会导致它们陷入死锁:

1 | X a{ "1" }, b{ "2" }; |

1执行的时候,先上锁 a 的互斥量,再上锁 b 的互斥量。2执行的时候,先上锁 b 的互斥量,再上锁 a 的互斥量。